Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Victor M

🤗 Jefe de @huggingface de Producto

Victor M reposteó

Acabamos de publicar 3 millones de muestras de conjunto de datos de entrenamiento de modelos de lenguaje de visión de alta calidad para casos de uso como:

📄 reconocimiento óptico de caracteres (OCR)

📊 respuesta visual a preguntas (VQA)

📝 Subtitulación

🤗 Aprende más:

📥 Descargar:

80.28K

Victor M reposteó

Ahora puede ajustar @Alibaba_Qwen Qwen-Image con AI Toolkit con 24 GB de VRAM utilizando un adaptador de recuperación de precisión entrenado personalizado que le permite ajustar con precisión de 3 bits con una pérdida de precisión mínima. Los cambios marcados en los valores predeterminados deberían funcionar para las GPU 3090/4090. Más en 🧵

15.77K

Victor M reposteó

Realmente me gusta mucho @jandotai

Es una aplicación muy amigable para ejecutar LLM localmente, ideal para la privacidad

He probado otros como LM Studio y Ollama y son agradables pero muy construidos por ingenieros, un poco demasiado difíciles para mí

Jan es simple, lindo y bonito y una excelente alternativa para hablar sin enviar sus datos (y secretos ;)) a grandes proveedores de IA

Incluso puede ejecutar modelos de proveedores remotos a través de API, ¡si lo desea!

También son muy receptivos a los comentarios y siempre mejoran la aplicación

Creo que hay espacio tanto para aplicaciones LLM ejecutadas localmente como para aplicaciones LLM en la nube, las aplicaciones LLM ejecutadas localmente tienen sentido si quieres hablar de cosas muy privadas, terapia, etc. Es muy importante que las personas puedan tener eso sin temor a que sus datos se filtren en el futuro

(No estoy afiliado ni pagado, ¡simplemente me gusta!)

218.33K

Victor M reposteó

Presentamos Jan-v1: modelo 4B para búsqueda web, una alternativa de código abierto a Perplexity Pro.

En nuestras evaluaciones, Jan v1 ofrece una precisión de SimpleQA del 91%, superando ligeramente a Perplexity Pro mientras se ejecuta completamente localmente.

Casos de uso:

- Búsqueda web

- Investigación profunda

Construido sobre la nueva versión de Qwen's Qwen3-4B-Thinking (hasta 256k de longitud de contexto), ajustado para el razonamiento y el uso de herramientas en enero.

Puede ejecutar el modelo en enero, llama.cpp o vLLM. Para habilitar la búsqueda en enero, vaya a Configuración → Funciones experimentales → Activado, luego Configuración → Servidores MCP → habilitar un MCP relacionado con la búsqueda como Serper.

Utilice el modelo:

- Enero-v1-4B:

- Enero-v1-4B-GGUF:

Crédito al equipo de @Alibaba_Qwen por Qwen3 4B Thinking & @ggerganov por llama.cpp.

633.24K

Qwen-Image + Wan-2.2 = 🔥

Victor M12 ago, 06:19

¡Estoy tan emocionado de que ahora podamos generar videos de esta calidad en menos de 30 segundos! ¡Código abierto para ganar!

👇Prueba Wan 2.2 (con Lightning LoRA) en Hugging Face

1.2K

Victor M reposteó

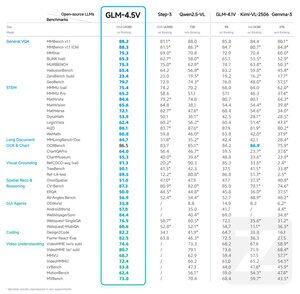

Presentamos GLM-4.5V: un avance en el razonamiento visual de código abierto

GLM-4.5V ofrece un rendimiento de vanguardia entre los modelos de código abierto en su clase de tamaño, dominando en 41 benchmarks.

Construido sobre el modelo base GLM-4.5-Air, GLM-4.5V hereda técnicas probadas de GLM-4.1V-Thinking mientras logra una escalabilidad efectiva a través de una poderosa arquitectura MoE de 106B parámetros.

Hugging Face:

GitHub:

API:

Pruébalo ahora:

264.76K

Populares

Ranking

Favoritas

Onchain en tendencia

Tendencia en X

Principales fondos recientes

Más destacadas