Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Victor M

🤗 Responsabile del @huggingface di prodotto

Victor M ha ripubblicato

Ora puoi ottimizzare @Alibaba_Qwen Qwen-Image con AI Toolkit utilizzando 24 GB di VRAM con un adattatore di recupero dell'accuratezza personalizzato che ti consente di ottimizzare a 3 bit con una minima perdita di precisione. Le modifiche contrassegnate ai valori predefiniti dovrebbero funzionare per le GPU 3090/4090. Maggiori informazioni in 🧵

15,77K

Victor M ha ripubblicato

Mi piace davvero tanto @jandotai

È un'app molto amichevole per eseguire localmente LLM, ottima per la privacy

Ho provato altre come LM Studio e Ollama e sono carine, ma molto ingegnerizzate, un po' troppo difficili per me

Jan è semplice, carina e bella ed è una grande alternativa per parlare senza inviare i tuoi dati (e segreti ;)) ai grandi fornitori di intelligenza artificiale

Puoi anche eseguire modelli di fornitori remoti tramite API, se lo desideri!

Inoltre, sono molto reattivi ai feedback e stanno sempre migliorando l'app

Penso che ci sia spazio sia per le app LLM eseguite localmente che per quelle in cloud, eseguite localmente ha senso se vuoi parlare di cose molto private, terapia ecc. È davvero importante che le persone possano avere questo senza temere che i loro dati possano trapelare in futuro

(Non sono affiliato né pagato, mi piace davvero!)

218,33K

Victor M ha ripubblicato

Presentiamo Jan-v1: modello 4B per la ricerca web, un'alternativa open-source a Perplexity Pro.

Nei nostri test, Jan v1 offre un'accuratezza del 91% in SimpleQA, superando leggermente Perplexity Pro mentre funziona completamente in locale.

Casi d'uso:

- Ricerca web

- Ricerca approfondita

Costruito sulla nuova versione di Qwen's Qwen3-4B-Thinking (fino a 256k di lunghezza del contesto), ottimizzato per il ragionamento e l'uso degli strumenti in Jan.

Puoi eseguire il modello in Jan, llama.cpp o vLLM. Per abilitare la ricerca in Jan, vai su Impostazioni → Funzioni Sperimentali → Attiva, poi Impostazioni → Server MCP → abilita un MCP relativo alla ricerca come Serper.

Usa il modello:

- Jan-v1-4B:

- Jan-v1-4B-GGUF:

Credito al team @Alibaba_Qwen per Qwen3 4B Thinking e a @ggerganov per llama.cpp.

633,24K

Qwen-Image + Wan-2.2 = 🔥

Victor M12 ago, 06:19

Sono così entusiasta che ora possiamo generare video di questa qualità in meno di 30 secondi. Open source per la vittoria!

👇Prova Wan 2.2 (con Lightning LoRA) su Hugging Face

1,2K

Victor M ha ripubblicato

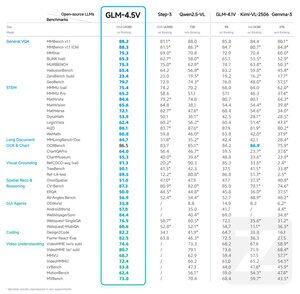

Presentiamo GLM-4.5V: una svolta nel ragionamento visivo open-source

GLM-4.5V offre prestazioni all'avanguardia tra i modelli open-source nella sua classe di dimensioni, dominando in 41 benchmark.

Costruito sul modello base GLM-4.5-Air, GLM-4.5V eredita tecniche collaudate da GLM-4.1V-Thinking mentre raggiunge una scalabilità efficace attraverso una potente architettura MoE con 106 miliardi di parametri.

Hugging Face:

GitHub:

API:

Provalo ora:

264,76K

Principali

Ranking

Preferiti

On-chain di tendenza

Di tendenza su X

Principali fondi recenti

Più popolari