Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Tomasz Tunguz

Quando a Anthropic introduziu o Protocolo de Contexto do Modelo, prometeram simplificar o uso de agentes.

O MCP permite que uma IA entenda quais ferramentas estão à sua disposição: pesquisa na web, edição de arquivos e redação de e-mails, por exemplo.

Dez meses depois, analisamos 200 ferramentas MCP para entender quais categorias os desenvolvedores realmente usam.

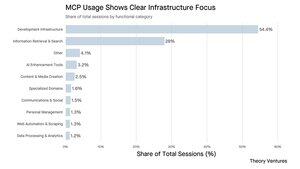

Três padrões de uso emergiram dos dados:

As ferramentas de infraestrutura de desenvolvimento dominam com 54% de todas as sessões, apesar de serem apenas metade dos servidores disponíveis. Acesso ao terminal, geração de código e acesso à infraestrutura são as mais populares.

Enquanto codificam, os engenheiros se beneficiam da capacidade de enviar para o GitHub, executar código em um terminal e criar bancos de dados. Essas ferramentas agilizam os fluxos de trabalho e reduzem a troca de contexto.

A recuperação de informações captura 28% das sessões com menos ferramentas, mostrando alta eficiência. Pesquisa na web, bases de conhecimento e recuperação de documentos são os principais players. Esses sistemas são provavelmente usados mais em produção, em nome dos usuários, do que durante o desenvolvimento.

Tudo o mais, incluindo entretenimento, gestão pessoal e criação de conteúdo, divide os restantes 18%. Recomendadores de filmes, gerenciadores de tarefas e horários da Fórmula 1 preenchem nichos específicos.

A adoção do MCP ainda é inicial. Nem todas as IAs suportam o MCP. Das que o fazem, Claude, Claude Code e Cursor estão no topo da lista (aliteracão em IA). Produtos focados em desenvolvedores e primeiros adotantes técnicos são a maioria dos usuários.

Mas à medida que o uso de ferramentas de IA pelos consumidores cresce e o suporte ao MCP se amplia, devemos esperar ver uma diversidade muito maior no uso de ferramentas.

3,41K

$4 mil milhões em receita anualizada. Existem dois gigantes de dados, ambos agora neste patamar, após a Databricks anunciar que ultrapassou o limite.

Esta é uma oportunidade para comparar as duas principais empresas de dados em uma interseção de receita.

Ambas estão com $4 mil milhões em receita. Cada uma afirma ter mais de 650 clientes pagando mais de $1M anualmente. Cada uma exibe uma forte retenção líquida de dólares (140% contra 125%).

A Databricks está crescendo a 50% em comparação com os 28% da Snowflake e, no mercado privado, é negociada a um prêmio por essa taxa de crescimento. A Snowflake reacelerou, mas foi cerca de um ano depois da Databricks.

Comparar a avaliação com a receita anualizada mostra que a Databricks está sendo negociada a um prêmio de 35% em relação à Snowflake.

A Databricks é avaliada em $100B no mercado privado, enquanto a Snowflake é negociada a $75,9B publicamente. Neste mercado, cada 1% de crescimento adiciona 0,3x ao múltiplo de avaliação. Dada a vantagem de crescimento de 22 pontos da Databricks, o prêmio de 35% pode, na verdade, subestimar a verdadeira diferença no tamanho final do negócio.

Esse prêmio reflete a escassez de plataformas de dados de alto crescimento nos mercados públicos. Realmente não há equivalente à Databricks hoje. A Palantir, com 39% de crescimento, é negociada a 75x para frente (não anualizada). A Rubrik, na fase final de uma transição de on-prem para nuvem, é negociada a 15x para frente com 44% de crescimento.

O prêmio de avaliação de 35% reflete tanto o crescimento superior da Databricks quanto a aposta do mercado em IA. Com a receita de IA já em $1B e impulsionando a demanda de computação concomitante, a Databricks se posicionou no centro da tendência mais valiosa em software empresarial.

1. $100b/$4b = 25x contra $75.9b/$4.1b 18.5x

10,35K

Top

Classificação

Favoritos