Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

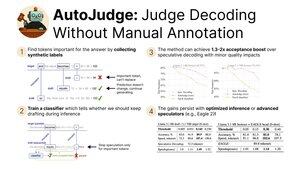

Ravi de partager notre récente recherche sur AutoJudge, une technique de décodage qui combine :

- Accélération de l'inférence grâce à l'assouplissement de la contrainte d'adéquation de distribution

- Facilité d'utilisation et évolutivité grâce à un protocole d'entraînement auto-supervisé

Présentation à #NeurIPS2025 aujourd'hui ! (1/9)

Nous constatons que nous pouvons extraire automatiquement les étiquettes pour le classificateur d'acceptation. Plus précisément, nous prenons un ensemble de données et exécutons des générations de modèles cibles et de brouillons.

Ensuite, nous vérifions tous les jetons non correspondants entre les modèles cibles et de brouillons. Si le maintien du jeton du modèle de brouillon entraîne une mauvaise réponse, il est marqué comme important (3/9)

En utilisant ces étiquettes, nous pouvons entraîner un classificateur simple pour trouver des tokens importants au moment de l'inférence.

Si le décodage spéculatif original rejetait un token, nous lui donnons une seconde chance en demandant au classificateur. Pour les tokens non importants, nous continuons la génération, mais pour les autres, nous commençons un nouveau cycle spéculatif (4/9)

Nos principales évaluations d'AutoJudge se concentrent sur des tâches pour lesquelles il est facile de mesurer la justesse des réponses — programmation (LiveCodeBench) et mathématiques (GSM8K).

Avec des paires de modèles telles que 8B/70B, nous pouvons atteindre jusqu'à 40 tokens acceptés par cycle avec une précision de <1% ! (5/9)

AutoJudge s'intègre également facilement avec des frameworks d'inférence open-source tels que vLLM. Les améliorations du taux d'acceptation se traduisent par des gains de vitesse de bout en bout : si nous échangeons 2 % de précision, nous obtenons presque 50 % de tokens supplémentaires par seconde ! (6/9)

L'inspection des annotations pour les jetons importants révèle un schéma curieux : les erreurs claires sont marquées comme des échantillons négatifs (=> besoin de régénérer), tandis que les jetons sémantiquement équivalents permettent à la spéculation de se poursuivre (7/9)

Pour en savoir plus, consultez :

Document :

Code :

Article de blog :

Activations précalculées pour GSM8K & LiveCodeBench :

(8/9)

Ce travail a été dirigé par mes incroyables co-auteurs @garipovroma, @MightyNeighbour, Ivan Ermakov, Ruslan Svirschevski et Vage Egiazarian.

L'équipe est à San Diego pour NeurIPS cette semaine — venez dire bonjour aujourd'hui lors de la session d'affiches !

16h30, affiche #2010 (9/9)

758

Meilleurs

Classement

Favoris