Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

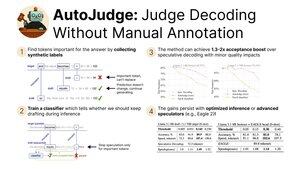

Animado em compartilhar nossa pesquisa recente sobre o AutoJudge, uma técnica de decodificação que combina:

- Aceleração da inferência por meio do relaxamento da restrição de correspondência de distribuição

- Facilidade de uso e escalabilidade devido a um protocolo de treinamento auto-supervisionado

Apresentando no #NeurIPS2025 hoje! (1/9)

Descobrimos que podemos extrair automaticamente os rótulos para o classificador de aceitação. Especificamente, pegamos um conjunto de dados e rodamos gerações de modelos-alvo e rascunho.

Depois, verificamos todos os tokens que não combinam entre os modelos alvo e draft. Se manter o token do modelo de draft resultar na resposta errada, ele é marcado como importante (3/9)

Usando esses rótulos, podemos treinar um classificador simples para encontrar tokens importantes no momento da inferência.

Se a decodificação especulativa original rejeitaria um token, damos uma segunda chance perguntando ao classificador. Para tokens não importantes, continuamos a geração, mas para outros iniciamos um novo ciclo especulativo (4/9)

Nossas principais avaliações do AutoJudge focam em tarefas para as quais é fácil medir a correção das respostas — programação (LiveCodeBench) e matemática (GSM8K).

Com pares de modelos como 8B/70B, podemos alcançar até 40 tokens aceitos por ciclo com um acerto de <1% na precisão! (5/9)

O AutoJudge também se integra facilmente com frameworks de inferência open-source, como vLLM. As melhorias na taxa de aceitação se traduzem em acelerações de ponta a ponta: se trocarmos 2% de precisão, recebemos quase 50% a mais tokens por segundo! (6/9)

Inspecionar as anotações para tokens importantes revela um padrão curioso: erros claros são marcados como amostras negativas (=> precisam regenerar), enquanto tokens semanticamente equivalentes permitem que a especulação prossiga (9/7)

Para saber mais, confira:

Papel:

Código:

Post no blog:

Ativações pré-computadas para GSM8K e LiveCodeBench:

(8/9)

Esse trabalho foi liderado pelos meus incríveis coautores @garipovroma, @MightyNeighbour, Ivan Ermakov, Ruslan Svirschevski e Vage Egiazarian.

A equipe está em San Diego para o NeurIPS esta semana — venha cumprimentar hoje na sessão de pôsteres!

16h30, pôster #2010 (9/9)

753

Melhores

Classificação

Favoritos