Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

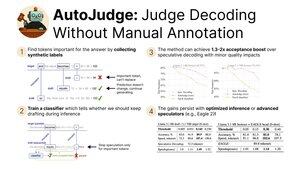

Ich freue mich, unsere aktuelle Forschung zu AutoJudge zu teilen, einer Decodierungstechnik, die Folgendes kombiniert:

- Beschleunigung der Inferenz durch Lockerung der Verteilungsübereinstimmungsbeschränkung

- Benutzerfreundlichkeit und Skalierbarkeit dank eines selbstüberwachten Trainingsprotokolls

Präsentation heute bei #NeurIPS2025! (1/9)

Wir stellen fest, dass wir die Labels für den Akzeptanzklassifikator automatisch generieren können. Konkret nehmen wir einen Datensatz und führen Ziel- und Entwurfmodell-Generierungen durch.

Dann überprüfen wir alle nicht übereinstimmenden Tokens zwischen Ziel- und Entwurfmodellen. Wenn das Beibehalten des Tokens aus dem Entwurfmodell zu einer falschen Antwort führt, wird es als wichtig markiert (3/9)

Mit diesen Labels können wir einen einfachen Klassifikator trainieren, um wichtige Tokens zur Inferenzzeit zu finden.

Wenn das ursprüngliche spekulative Decoding ein Token ablehnen würde, geben wir ihm eine zweite Chance, indem wir den Klassifikator fragen. Für nicht wichtige Tokens setzen wir die Generierung fort, aber für andere beginnen wir einen neuen spekulativen Zyklus (4/9)

Unsere Hauptbewertungen von AutoJudge konzentrieren sich auf Aufgaben, bei denen es einfach ist, die Richtigkeit der Antworten zu messen – Programmierung (LiveCodeBench) und Mathematik (GSM8K).

Mit Modellpaaren wie 8B/70B können wir bis zu 40 akzeptierte Tokens pro Zyklus mit einer Genauigkeitseinbuße von <1% erreichen! (5/9)

AutoJudge lässt sich auch problemlos mit Open-Source-Inferenz-Frameworks wie vLLM integrieren. Die Verbesserungen der Akzeptanzrate führen zu End-to-End-Geschwindigkeitssteigerungen: Wenn wir 2 % Genauigkeit opfern, erhalten wir fast 50 % mehr Tokens pro Sekunde! (6/9)

Die Überprüfung der Annotationen für wichtige Tokens zeigt ein interessantes Muster: klare Fehler werden als negative Proben markiert (=> müssen regeneriert werden), während semantisch äquivalente Tokens die Spekulation ermöglichen (7/9)

Um mehr zu erfahren, schauen Sie sich Folgendes an:

Papier:

Code:

Blogbeitrag:

Vorab berechnete Aktivierungen für GSM8K & LiveCodeBench:

(8/9)

Diese Arbeit wurde von meinen großartigen Mitautoren @garipovroma, @MightyNeighbour, Ivan Ermakov, Ruslan Svirschevski und Vage Egiazarian geleitet.

Das Team ist diese Woche in San Diego für NeurIPS – kommt heute zur Postersession vorbei und sagt Hallo!

16:30 Uhr, Poster #2010 (9/9)

769

Top

Ranking

Favoriten