Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

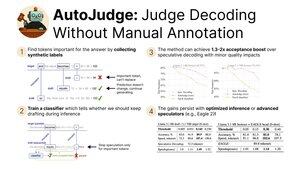

Siamo entusiasti di condividere la nostra recente ricerca su AutoJudge, una tecnica di decodifica che combina:

- Accelerazione dell'inferenza grazie al rilassamento del vincolo di corrispondenza della distribuzione

- Facilità d'uso e scalabilità grazie a un protocollo di addestramento auto-supervisionato

Presentiamo oggi a #NeurIPS2025! (1/9)

Scopriamo che possiamo estrarre automaticamente le etichette per il classificatore di accettazione. In particolare, prendiamo un dataset e eseguiamo generazioni di modelli target e bozza.

Poi, controlliamo tutti i token non corrispondenti tra i modelli target e bozza. Se mantenere il token dal modello bozza porta a una risposta errata, viene contrassegnato come importante (3/9)

Utilizzando queste etichette, possiamo addestrare un semplice classificatore per trovare token importanti al momento dell'inferenza.

Se il decodificatore speculativo originale rifiuterebbe un token, gli diamo una seconda possibilità chiedendo al classificatore. Per i token non importanti, continuiamo la generazione, ma per gli altri iniziamo un nuovo ciclo speculativo (4/9)

Le nostre principali valutazioni di AutoJudge si concentrano su compiti per i quali è facile misurare la correttezza delle risposte — programmazione (LiveCodeBench) e matematica (GSM8K).

Con coppie di modelli come 8B/70B, possiamo raggiungere fino a 40 token accettati per ciclo con un <1% di perdita in accuratezza! (5/9)

AutoJudge si integra facilmente anche con framework di inferenza open-source come vLLM. I miglioramenti del tasso di accettazione si traducono in velocità end-to-end: se scambiamo il 2% di accuratezza, otteniamo quasi il 50% in più di token al secondo! (6/9)

Ispezionare le annotazioni per i token importanti rivela un curioso schema: errori chiari sono contrassegnati come campioni negativi (=> necessità di rigenerare), mentre i token semanticamente equivalenti consentono di proseguire con la speculazione (7/9)

Per saperne di più, dai un'occhiata a:

Documento:

Codice:

Post del blog:

Attivazioni precompute per GSM8K e LiveCodeBench:

(8/9)

Questo lavoro è stato guidato dai miei fantastici coautori @garipovroma, @MightyNeighbour, Ivan Ermakov, Ruslan Svirschevski e Vage Egiazarian.

Il team è a San Diego per NeurIPS questa settimana — vieni a salutarci oggi alla sessione dei poster!

16:30, poster #2010 (9/9)

771

Principali

Ranking

Preferiti