Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

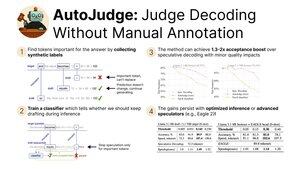

Gleder meg til å dele vår nylige forskning på AutoJudge, en dekodingsteknikk som kombinerer:

- Akselerasjon av inferensen ved å slakke på fordelingsmatchbetingelsen

- Brukervennlighet og skalerbarhet takket være en selvovervåket treningsprotokoll

Presenterer på #NeurIPS2025 i dag! (1/9)

Vi finner ut at vi automatisk kan utvinne etikettene for akseptklassifikatoren. Spesifikt tar vi et datasett og kjører mål- og utkastmodellgenereringer.

Deretter sjekker vi alle mismatch-tokens mellom mål- og draftmodellene. Hvis det å beholde tokenet fra utkastmodellen gir feil svar, markeres det som viktig (3/9)

Ved å bruke disse etikettene kan vi trene en enkel klassifisator til å finne viktige tokens ved slutningstidspunkt.

Hvis den opprinnelige spekulative dekodingen ville avvise et token, gir vi det en ny sjanse ved å spørre klassifikatoren. For ikke-viktige tokens fortsetter vi genereringen, men for andre starter vi en ny spekulativ syklus (4/9)

Våre hovedevalueringer av AutoJudge fokuserer på oppgaver hvor det er enkelt å måle svarkorrekthet — programmering (LiveCodeBench) og matematikk (GSM8K).

Med modellpar som 8B/70B kan vi oppnå opptil 40 aksepterte tokens per syklus med <1 % treff i nøyaktighet! (5/9)

AutoJudge integreres også enkelt med åpen kildekode-inferensrammeverk som vLLM. Forbedringene i akseptraten gir hastighetsøkninger fra ende til ende: hvis vi bytter ut 2 % av nøyaktigheten, får vi nesten 50 % flere tokens per sekund! (6/9)

Inspeksjon av annotasjonene for viktige tokens avslører et merkelig mønster: klare feil markeres som negative prøver (=> må regenerere), mens semantisk ekvivalente tokens tillater spekulasjonen å fortsette (7/9)

For å lære mer, sjekk ut:

Papir:

Kode:

Blogginnlegg:

Forhåndsberegnede aktiveringer for GSM8K og LiveCodeBench:

(8/9)

Dette arbeidet ble ledet av mine fantastiske medforfattere @garipovroma, @MightyNeighbour, Ivan Ermakov, Ruslan Svirschevski og Vage Egiazarian.

Teamet er i San Diego for NeurIPS denne uken — kom og si hei i dag på plakatsesjonen!

16:30, plakat #2010 (9/9)

761

Topp

Rangering

Favoritter