Trend Olan Konular

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

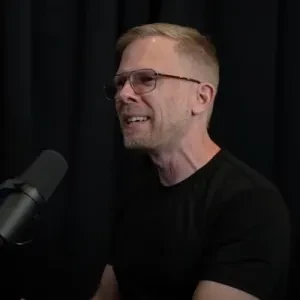

John Carmack

Keen Technologies'de AGI, eski CTO Oculus VR, Id Software ve Armadillo Aerospace'in Kurucusu

#PaperADay 8

Paralel Optimizasyonda Gradient Ortalamanın Ötesinde: Gradient Uyumu Filtreleme Yoluyla Geliştirilmiş Dayanıklılık

Dün makalesinden sonra @FrancoisChauba1 tarafından tavsiye edildi.

Aralarında büyük kosinüs mesafeleri olan bağımsız gradyanların ortalamanın alınmadığı Gradient Anlaşma Filtreleme (GAF) önerir. İma olarak, eğitim kaybına yardımcı olabilecek bazı hesaplanmış gradyanların genellemeye aktif olarak zarar verdiği ve kullanılmak yerine atılması gerektiği yönündedir.

Bu, çoklu GPU dağıtık eğitimde mikro partiler olarak sunulur, ancak aynı fikir herhangi bir eğitim partisinin bölümleri için de geçerlidir.

Tesadüfen benzer bir şey deniyordum – IID tekrar tampon örneklerinden gradyanları kesmek, böylece mevcut çevrimiçi deneyim örneğiyle çelişmemek için. Henüz olumlu sonuçlar vermedi ama denemem gereken birkaç açı daha var.

Teoriyi motive eden gözlem, bir görüntü sınıflayıcısını tamamen rastgele gürültü ve rastgele etiketler üzerine eğittiğinizde, %100 eğitim doğruluğuna ve sadece rastgele şans doğrulama doğruluğuna sahip olacağı, bu da eğitim verisine açıkça fazla uyum sağlamasıdır. Bu overfit modelinde minibatch'lerin gradyanları arasındaki kosinüs benzerliğine bakarsanız, her zaman 0.99'un üzerinde, yani esasen ortogonal olduğunu belirtiyorlar. Eğer ortogonal gradyanlar aşırı uyumun güvenilir bir işaretiyse, ortogonal gradyanlı minbatch'leri atlayıp aşırı uyumu azaltabilir / genelleştirmeyi artırabilirsin.

İki mikropartinin en basit durumunda, bu kosinüs benzerliğine göre her ikisini de tutmak ya da reddetmek anlamına gelir, ancak daha fazla mikroparti ile tüm mikro partileri ilk partiyle karşılaştırmak ve testi geçenlerin ortalamasını toplamak önerilir.

Parti boyutuyla ilgili bazı yorumlar, #PaperADay 5'teki tezle çelişiyor; bu tezde parti boyutu ölçeklendirme hatalarının beta2'yi ayarlamamaktan kaynaklandığını iddia ediyor, ancak gerekçeler ampirik performans kadar önemli değil. Muhtemelen önümüzdeki birkaç gün içinde gerçek tarihli kod tabanımızda buna benzer bir şey deneyeceğim.

116

#PaperADay 6

PEKIŞTIRME ÖĞRENIMINDE GENELLEŞTIRME IÇIN YEREL ÖZELLIK DEĞIŞIMI

Genelleştirme üzerine genel (ha) ve daha spesifik olarak gerçek hayatta iyi bir tartışma var, ama sunulan fikir çok basit ve ben deneyeceğim:

CLOP: Kanal tutarlı yerel permütasyonlar

Bir 3D tensör (parti ile 4D) verildiğinde, her konumda belli bir olasılıkla, rastgele bir komşu ile pozisyon değiştirin, tüm kanallar birim olarak değiştirilir. Dropout gibi, bu da aşırı uyumu birlikte uyarlayarak azaltır, ama hiçbir kanalı sıfırlamıyor, sadece hareket ettiriyor.

Gizli alandaki veri artırmanın, girdi alanına göre genelleme açısından daha verimli olduğu fikrine katılıyorum. Bunu mekânsal hiyerarşide mümkün olduğunca alt seviyede yapmak öneriliyor, ama muhtemelen sadece dört olası permütasyon olduğu ve herhangi birinin mekânsal bilginin yarısını bozduğu 2x2 seviyesinde iyi bir fikir olmaz.

Oyun başına değişim şansını ayarladıklarını unutmayın, bu genellikle bir oyun setinde sonuç raporlarken yapılmaz.

Saf denetimli öğrenme görevlerindeki sonuçlar dikkat çekici değildi, ancak CLOP farklı yerlere ve farklı eğitim tarifleriyle daha iyi olabilir.

881

Gary Gygax, genç bir D&D oyuncusu olarak kahramanlar panteonumdaydı ama bu kitabı okumadan önce onun hakkında pek bir şey bilmiyordum. En yakın olduğum şey, 13 yaşındayken babamın tanıdığı ve Dragonlance yazarlarından biri olan Margaret Weis'e telefonla onun hakkında sormak oldu.

D&D'nin daha geniş etkisi (Id Software'deki oyunlar sonlara yakın kısaca bahsedilmişti) onun finansal getirisini çok daha aştı ve yolu oldukça zorluydu, ama sonunda "nerdlerin kralı" olarak oldukça iyi bir konuma yerleşmiş gibi görünüyor.

69 yaşında çok kötü sağlık sorunlarından sonra ölmek, 50'li yaşlarımızda olanlara kendimize iyi bakmamız gerektiğini hatırlatıyor.

@MikeWitwer

761

En İyiler

Sıralama

Takip Listesi