Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

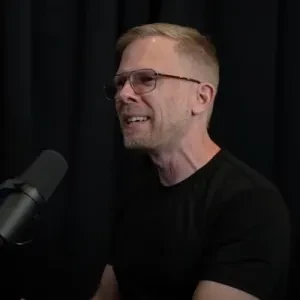

John Carmack

AGI na Keen Technologies, ex-CTO Oculus VR, fundador da Id Software e Armadillo Aerospace

#PaperADay 12

2019: Aprendendo Dinâmicas Latentes para Planejamento a partir de Pixels (PlaNet)

Este foi o precursor da série de agentes / artigos Dreamer 1/2/3/4 de RL, que vou ler em sequência.

O planejamento é comum em tarefas com dinâmicas de transição e recompensa totalmente especificadas, como jogos de tabuleiro, mas é muito mais desafiador quando você tem que aprender as "regras do jogo" ao mesmo tempo que está tentando melhorar seu desempenho, especialmente ao tentar fazer isso a partir de pixels brutos em vez de características de estado perfeitamente observadas.

Às vezes, defendo semi-brincando a posição de que "planejamento" pode não ser realmente uma coisa, pelo menos em níveis baixos como este, e parece apenas planejamento quando experiências relevantes são chamadas da memória e o treinamento bootstrap nelas resulta em mudanças na decisão de política atual. Há um artigo clássico da Atari que argumenta que buffers de replay *são* uma espécie de modelo de mundo não paramétrico.

Este artigo alcança desempenho máximo "perto de" algoritmos fortes sem modelo, mas com muito menos experiência do mundo real necessária, porque a maior parte do trabalho está acontecendo no planejamento. Muitas vezes, métodos baseados em modelo têm que lutar para alcançar paridade com os algoritmos mais simples sem modelo, e isso ainda está acontecendo com o benchmark Atari100k hoje.

Este é um sistema clássico baseado em modelo com um modelo de transição de estado e recompensa. O maior problema com modelos de transição é geralmente que os erros se acumulam rapidamente, então você não pode prever muitos passos no futuro.

Os modelos de transição pegam um estado mais uma ação e preveem o próximo estado e a recompensa que resulta da ação. Uma das principais descobertas do artigo foi que tentar aprender um modelo de transição determinístico basicamente falhou. Um modelo estocástico poderia ser treinado, mas o desempenho melhorou quando combinaram cálculos determinísticos e estocásticos no modelo.

Olhar de perto para os quadros de previsão de vídeo no apêndice H é interessante: uma vez que o modelo de transição GRU determinístico perdeu o enredo em um quadro, tudo depois permaneceu quebrado, enquanto o modelo estocástico poderia transitar para algo sem sentido em um quadro, mas depois voltar para algo sensato em seguida. Eu não teria adivinhado isso. O modelo combinado completo deles deu previsões boas ao longo de todo o tempo.

Não há rede de política ou valor como em RL sem modelo. As ações são selecionadas tentando uma sequência delas usando as funções de transição e recompensa modeladas, e a ação que levou aos melhores resultados é tomada. Milhares de sequências de ações são avaliadas para cada ação selecionada, mas como operam em vetores latentes compactos, isso é relativamente eficiente. O Método de Entropia Cruzada (CEM) é usado para planejar múltiplos passos à frente com os modelos de transição. Isso tem que ser heurístico para espaços de ação contínuos ou qualquer coisa além de alguns passos modelados no futuro.

A entrada para a rede de estado é uma observação RGB de 64x64 (quantizada para 5 bits como GLOW; não estou claro por que isso é necessário). Durante o treinamento, eles têm um modelo de observação que tenta voltar de um estado para uma observação de pixel. Isso é geralmente impossível de fazer perfeitamente quando o estado é menor que a imagem, mas tentar isso fornece um rico sinal de feedback sobre o que colocar no estado. Isso não é usado para nenhuma parte do processo de decisão de ação, é apenas uma ajuda ao treinamento.

Repetição de ação de 2 a 8, dependendo da tarefa.

Overshooting latente como um regularizador no espaço latente que incentiva previsões iteradas de um passo e múltiplos passos a corresponder.

1,99K

Os rotores de volante de inércia compostos de alta qualidade podem alcançar quase 1 kWh/kg de armazenamento rotacional quando levitados magneticamente em uma câmara de vácuo. Considere montar um volante no meio de uma roda, de modo que desacelerar magneticamente o volante acelere a roda. Mesmo que o volante fosse apenas 1% da massa do sistema, isso seria 0,01 kWh/kg, energia suficiente para acelerar todo o sistema a 600 mph.

Muitos desafios práticos de engenharia de sistemas, e a resistência consumiria mais energia, mas seria divertido ultrapassar um dragster de combustível top com um brinquedo de corda.

67

#PaperADay 10

LeJEPA: Aprendizagem Auto-Supervisionada Provável e Escalável Sem Heurísticas

Os comentários sobre #PaperADay 3 recomendaram este artigo como o artigo JEPA de ponta, e realmente parece muito melhor!

Eles reconhecem que grande parte da pesquisa anterior sobre JEPA é ad-hoc e cheia de heurísticas, mas aqui fazem fortes afirmações teóricas de optimalidade e fornecem provas (que eu não li).

A primeira afirmação é que a gaussiana isotrópica é a única distribuição de incorporação ótima tanto para a sondagem linear quanto para a não linear, minimizando o risco no pior caso em tarefas subsequentes. Eu teria aceitado isso pela fé com apenas um "parece bom para mim", mas eles entram em detalhes e exemplos.

Na verdade, obter uma gaussiana isotrópica em altas dimensões é mais fácil dizer do que fazer. Eles apresentam a Regularização Gaussiana Isotrópica Esboçada (SIGReg) como uma função de perda bem comportada para alcançar isso após analisar uma série de testes estatísticos diferentes, e afirmam que ela supera a maldição da dimensionalidade com escalabilidade linear.

A perda final é apenas um fator de mistura para ponderar a perda de previsão do JEPA em relação à perda de isotropia do SIGReg. Este é o único hiperparâmetro ajustável para o LeJEPA.

Apesar do P em JEPA, eles não usam redes preditoras aqui, apenas comparam diretamente as incorporações de visualização para a perda do JEPA. Redes preditoras ainda poderiam ser úteis para sequências de vídeo, especialmente quando condicionadas com informações de ação para agentes / robôs.

Cada imagem de treinamento é aumentada para produzir 2 visualizações globais e 6 visualizações locais com diferentes escalas espaciais, mas o mesmo conjunto de transformações de cor e geométricas. A perda é a média do MSE entre a média das incorporações de visualização global e cada uma das incorporações de visualização local.

Não tenho uma boa noção dos trade-offs em suas transformações de visualização, que ainda parecem muito ad-hoc, mas elas determinarão a natureza do que é filtrado da representação. Aprender o que não importa é crítico, mas a especificação do que "importa" é apenas implícita nas transformações de visualização.

O LeJEPA em si é independente da arquitetura – qualquer coisa que digira um lote de amostras de um conjunto de dados em vetores pode ser usada. Transformadores de visão, MLP, ConvNets, etc. As ampliações específicas para visualizações seriam específicas do modo de entrada, mas o algoritmo LeJEPA poderia funcionar em áudio, imagens, vídeo ou outras coisas.

Eles mostram que a perda do LeJEPA em um grande modelo de base é muito indicativa do desempenho em tarefas subsequentes, tanto diretamente quanto com uma heurística para melhorar o poder preditivo da perda ainda mais.

Eles também mostram que pode ser usado para treinar do zero em pequenos conjuntos de dados com tão poucos quanto 1000 amostras e alcançar melhores resultados do que sondar um modelo de base geral convencional.

Fiquei satisfeito em ver blocos de código de exemplo no artigo em vez de pseudocódigo carregado de grego, assim como um repositório no github.

O Apêndice D tem detalhes interessantes sobre como gerar uma boa cobertura de hiperesferas unitárias com amostras de baixa discrepância transformando sequências de Sobol, mas isso é apenas para sua análise teórica, e eles mostram que é melhor simplesmente criar novos hipervetores aleatórios a cada lote, com até 16 vetores aleatórios superando um conjunto fixo de milhares.

Algumas perguntas:

Na discussão sobre sondagem não linear, apenas métodos kNN e de kernel são mencionados, presumivelmente por sua tratabilidade na análise teórica, mas um MLP geralmente não teria um desempenho melhor?

Uma incorporação JEPA não é totalmente reversível como NICE ou um RevNet, então como ela reage a entradas que estão muito fora do conjunto de treinamento? Entradas novas se mapearão para incorporações únicas, ou poderiam ser colapsadas nos códigos do conjunto de treinamento?

Como as incorporações evoluiriam em um ambiente de aprendizado contínuo, à medida que novas entradas são adicionadas à mistura de treinamento?

Um JEPA pode ser supertreinado – uma perda de treinamento mais baixa é sempre melhor, ou haveria um ponto ótimo de parada precoce?

924

Top

Classificação

Favoritos