Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

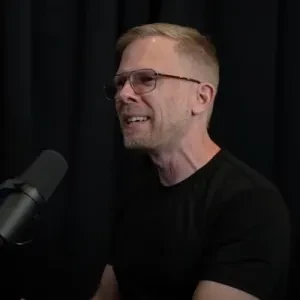

John Carmack

AGI hos Keen Technologies, tidligere CTO Oculus VR, grunnlegger av Id Software og Armadillo Aerospace

#PaperADay 15

2024: Å mestre mangfoldige domener gjennom verdensmodeller

(DreamerV3)

Bruker den nyeste Dreamer-modellen på over 150 forskjellige oppgaver, og får topp moderne poengsummer på mange av dem, men mest bemerkelsesverdig bruker den på diamantgruvedrift i Minecraft, en betydelig vanskeligere utfordring enn de fleste virkelige oppgaver.

Pressen rapporterte dette som «AI løser Minecraft», noe som er misvisende. Etter 30 millioner (20 Hz) miljøsteg (17 dager uten stopp) utvant den en diamant. I motsetning til Atari-spillene, som spilles med de samme pikslene og kontrollene som et menneske bruker, er dette et modifisert grensesnitt med inventar og statistikk presentert direkte til modellen, og et kategorisk handlingsområde – ingen musebevegelser rundt inventar- og håndverksskjermene.

Mining måtte endres til instant-break i stedet for det vanlige flersekunders inngrepet på gruveknappen fordi Dreamer bruker stokastiske handlingspolitikker, som nesten ikke klarer å holde inne en knapp i hundrevis av rammer på rad. På samme måte krevde hoppbevegelsen flere frames med holding, så det ble gjort umiddelbart.

Likevel var det første gang en RL-agent hadde kommet så langt uten å ha brukt imitasjonslæring fra menneskelige spillere, og betydelige forbedringer ble gjort på alle de andre benchmarkene også.

Forbedringene var stort sett ingeniørarbeid, snarere enn helt forskjellige arkitekturer. Jeg gikk glipp av «ting vi prøvde som ikke fungerte»-delen fra V2.

Med endringene kan de lønnsomt skalere modellen fra 12M til 400M parametere, og gjenspillingsraten fra 1 til 64 ganger miljøfrekvensen.

Artikkelterminologien ligner nå mer på andre RL-artikler: «Continue predictor» i stedet for «discount predictor» og bruker Pi for policynettverk. Diagrammene er forbedret.

Med de felles trente modellene er det en spenning mellom at representasjonsmodellen ønsker å degenerere for å gjøre prediksjon enklere og at den er nyttig for å forutsi påfølgende tilstander. Et av triksene de bruker er «gratis biter», som klipper tapene når de er under et visst nivå slik at de ikke prøver å kjøre helt til null, slik at motstanderen kan gjøre fremgang uten motstand.

For de kategoriske fordelingene bruker de 1 % etikettutjevning på de kategoriske fordelingene for å unngå topper i KL-tapet. De kaller dette "unimix" for å blande en jevn fordeling oppå den eksisterende fordelingen. Dette er ikke-standard (i motsetning til label-utjevning), men kan argumenteres for bedre terminologi.

De bruker en to-hot kategorisk verdi i stedet for MSE-regresjon for kritikeren, men i motsetning til de fleste andre implementasjoner, bruker de eksponentielt plasserte bins i stedet for lineært plasserte slik at de kan dekke flere størrelsesordener. De definerer funksjonene symlog() / symexp() for å la nettverkene håndtere svært varierende verdier i både positive og negative områder. Angivelig fungerer dette bedre enn den lignende ikke-lineære transformasjonen som brukes i MuZero og Muesli.

Dette krevde tilsynelatende en viss forsiktighet: «For å beregne forventet prediksjon av softmax-fordelingen under bins som spenner over mange størrelsesordener, betyr summeringsordenen noe, og positive og negative bins bør summeres separat, fra små til store bins, og deretter legges til.»

Det siste laget i belønnings- og kritikermodellene nullinitialiseres i stedet for tilfeldig for å unngå potensielt store falske verdier i starten av treningen.

Målmodellen for verdifunksjonen er nå en EMA i stedet for en periodisk kopi.

For å få samme mengde utforskning fra sin policygradient uavhengig av skalaen på verdifunksjonene, skalerer de de (eksponentielt fordelte, altså potensielt svært store) avkastningene til et begrenset område, og tar kun hensyn til intervallet 5 % til 95 % som anses å utelukke uteliggere.

De gjør 16-trinns prediksjon i fantasien, men valg av handlinger i virkelige miljøer skjer strengt etter policymodellen. Ytelsen kan sannsynligvis økes ved å gjøre imaginære lookaheads for hvert handlingsvalg som MuZero, på bekostning av mye tregere kjøretid.

3,03K

Jeg har fortsatt mange av de massemarkeds-pocketbøkene jeg leste som tenåring på 80-tallet. Samleutgaver lever fortsatt, men ja, det er en tidsalders falming.

Kendric Tonn30. jan. 2026

Mitt faste tema på middagsselskaper i det siste er å hevde at vi står rett forbi endepunktet for en distinkt lesekultur som varte fra tidlig på 1800-tallet til utgivelsen av den siste Harry Potter-boken.

347

#PaperADay 14

2022: MASTERING AV ATARI MED DISKRETE VERDENSMODELLER

(DreamerV2)

DreamerV1 var hovedsakelig rettet mot kontinuerlige kontrolloppgaver, men demonstrerte også grunnleggende spilling av Atari-spill og DMLab-oppgaver. DreamerV2 forbedret modellen slik at den oppnådde topp moderne ytelse på Atari-pakken med 55 spill, og løste også den vanskeligere oppgaven med kontinuerlig kontroll av humanoid gang.

Dette er virkelig en ingeniøroppgave, og jeg er med på den! I vedlegg C oppsummerer de endringene som førte til bedre ytelse, og også (veldig sjeldent i artikler!) en liste over ting de prøvde som ikke fungerte. Algoritmer vises i faktisk kode med navn i stedet for greske bokstaver.

Det er bemerkelsesverdig at de kun bruker 64x64 gråtoner som input, og disse ble nedskalert fra den vanlige 84x84-oppløsningen brukt av DQN, så det er ikke engang et perfekt 64x64-bilde fra kilden. Det er veldig uklare input for så gode poengsummer. Jeg er nysgjerrig på om bruk av 128x128xRGB-bilder med et ekstra konv-lag vil forbedre ytelsen, eller om den ekstra detaljrikdommen vil gjøre det vanskeligere for verdensmodellen å tre.

Deres største endring var å erstatte VAE-stilens gaussiske latente, som bare var 32 gjennomsnitt/var-par, med kategoriske variabler: 32 variabler i 32 kategorier. De har ikke en endelig teori om hvorfor dette er så mye bedre, men tilbyr flere teorier. Det ville vært interessant å sammenligne flere gaussere med de større kategoriske utgangene.

Den andre store algoritmiske endringen var «KL-balansering», altså å bruke en annen læringsrate for prior- og posteriorvektene, slik at prediktoren trener raskere enn representasjonen. Leddoptimaliseringen var tilsynelatende problematisk for V1.

DreamerV1 slet med utforskning, og hadde fortsatt en epsilon-tilfeldig handling i tillegg til stokastisk handlingspolicy. V2s forbedrede regulariserings- og dynamikkmodell gjør at de kan droppe den ekstra tilfeldigheten og stole utelukkende på policyen.

De gjør noen betydelige endringer i KL-taps- og treningsoppsettet for kontinuerlig kontroll versus diskrete Atari-kontrolloppgaver.

De skalerte også modellene opp og brukte ELU-aktivering overalt.

Deres Atari-evalueringsprotokoll er god: full handlingsplass med faste handlinger aktivert. Poengsummene er høye nok til at de anbefaler en ny måleparameter: «klippet rekordgjennomsnitt» – normaliser til menneskets verdensrekord, klipper hvis den er over det, og tar deretter gjennomsnittet av alle kampene. De historiske Atari RL-resultatene har sammenlignet seg med «menneskelige» scorer, som opprinnelig var noen tilfeldige personer, deretter til slutt en profesjonell gamer, men for kraftige agenter i 200M-rammeregimet har denne korte rekordmålingen noe for seg.

Under trening ble over 200 millioner virkelige miljørammer, eller 50 millioner handlingsvalg med action_repeat 4 468 milliarder latente tilstander, forestilt for nesten 10 ganger så mye erfaring som en modellfri agent ville hatt.

Den virkelige miljøopplevelsen trenes i grupper på 50 sekvenser med 50 steg hver. Sekvensene er begrenset for å ikke krysse episodegrenser.

Når man trener policy- og verdifunksjonene, rulles imaginære sekvenser ut i 15 trinn.

Verdiene er MSE-trent, ikke kategoriske. Et tradisjonelt målnettverk med verdi brukes, som oppdateres hvert 100. gradientsteg.

1,68K

Topp

Rangering

Favoritter