Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Du är på en intervju för forskare på OpenAI.

Intervjuaren frågar:

"Hur skulle du utöka kontextlängden för en LLM från 2K till 128K tokens?"

Du: "Jag finjusterar modellen på längre dokument med 128K kontext."

Intervjun är över.

Här är vad du missade:

Att utöka kontextfönstret handlar inte bara om större matriser.

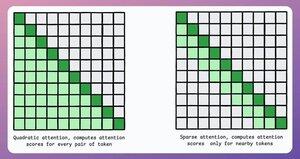

I en traditionell transformator ökar expansionen av tokens med 8x minnesbehovet med 64x på grund av den kvadratiska komplexiteten i uppmärksamheten. Se bilden nedan!

Så, hur hanterar vi det?

fortsätta... 👇

1) Sparsam uppmärksamhet

Den begränsar uppmärksamhetsberäkningen till en delmängd av token genom att:

- Använda lokal uppmärksamhet (tokens tar endast hand om sina grannar).

- Låta modellen lära sig vilka tokens som ska fokuseras på.

Men detta innebär en kompromiss mellan beräkningskomplexitet och prestanda.

En liknande idé användes i ModernBERT.

→ Full global uppmärksamhet varje tredje lager

→ Lokal uppmärksamhet (128 tokens) annars

Resultat:

- 16 gånger längre sekvenslängd

- Mycket bättre prestanda

- Den mest minneseffektiva kodaren

Enkel men kraftfull.

Här är en intuitiv förklaring hämtad från tidningen:

Föreställ dig att du läser en bok. För varje mening du läser, behöver du vara fullt medveten om hela handlingen för att förstå det mesta av den (full global uppmärksamhet)?

Eller räcker det med att vara medveten om det aktuella kapitlet (lokal uppmärksamhet), så länge du då och då tänker tillbaka på dess betydelse för huvudhandlingen (global uppmärksamhet)?

I de allra flesta fall är det det senare.

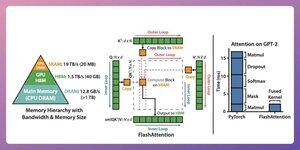

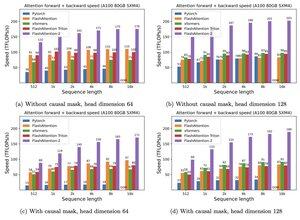

2) Blixt uppmärksamhet

Detta är en snabb och minneseffektiv metod som behåller exaktheten hos traditionella uppmärksamhetsmekanismer, dvs. den använder global uppmärksamhet men effektivt.

Hela idén kretsar kring att optimera dataförflyttningen i GPU-minnet.

Låt oss förstå!

Lite bakgrundsinformation:

- En tråd är den minsta körningsenheten.

- Flera trådar bildar ett block.

Också:

- Trådar i ett block delar ett snabbt (men knappt) minne som kallas SRAM.

- Alla block delar ett globalt minne som kallas HBM (abundant but slow).

Kolla in det här 👇

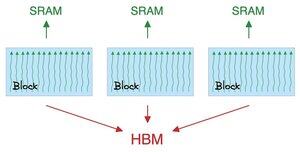

Uppmärksamheten rör sig mot stora matriser mellan SRAM och HBM:

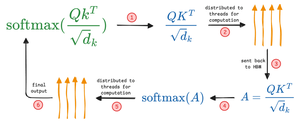

Så här beräknar du QK:

- fördela matriser till gängor

- beräkna, och

- skicka produkten till HBM

Så här beräknar du softmax:

- Distribuera produkten till gängor

- beräkna, och

- skicka utdata till HBM

Upprepa för alla lager.

Kolla in det här 👇

Flash-uppmärksamhet innebär optimeringar på hårdvarunivå där den använder SRAM för att cachelagra de mellanliggande resultaten.

På så sätt minskar den överflödiga rörelser och erbjuder en hastighet på upp till 7,6 gånger jämfört med vanliga uppmärksamhetsmetoder.

Kolla in det här 👇

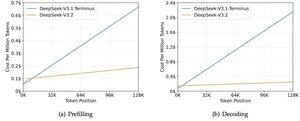

3) DeepSeek Sparse Attention (DSA)

DeepSeeks nya V3.2-modell introducerar DeepSeek Sparse Attention (DSA), som sänker komplexiteten från O(L²) till O(Lk), där k är fast.

Så här fungerar det:

En lättviktig Lightning Indexer bedömer vilka tokens som faktiskt är viktiga för varje fråga.

Litet antal huvuden, körs i FP8, beräkningsmässigt billigt.

Därefter hämtar en urvalsmekanism endast de högsta k nyckelvärdesposterna.

Den viktigaste insikten är att endast 2048 tokens väljs per fråga, oavsett kontextlängd.

Så den kostsamma uppmärksamhetsberäkningen sker på denna lilla delmängd, inte hela 128K-sekvensen.

Vid 128K kontext sjunker förfyllningskostnaderna från ~0,65 dollar till ~0,35 dollar per miljon tokens. Och avkodningen sjunker från ~2,4 till ~0,8 dollar.

Och prestandan förblir densamma. På vissa långkontext-benchmarks får V3.2 faktiskt högre poäng.

Gles uppmärksamhet är inget nytt. Men att få det att fungera utan att tappa kvalitet är svårt.

Vilka andra tekniker finns för att öka kontextlängderna för LLM:er?

152,61K

Topp

Rankning

Favoriter