Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jste na pohovoru na pozici výzkumného vědce ve společnosti OpenAI.

Tazatel se ptá:

"Jak byste rozšířil délku kontextu LLM z 2K na 128K tokenů?"

Vy: "Model doladím na delších dokumentech s kontextem 128K."

Pohovor skončil.

Tady je, co jste přehlédli:

Rozšíření kontextového okna se netýká jen větších matic.

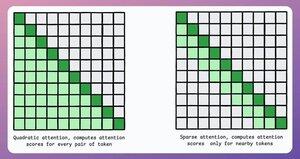

V tradičním transformátoru rozšíření tokenů 8x zvyšuje nároky na paměť 64x kvůli kvadratické složitosti pozornosti. Podívejte se na obrázek níže!

Jak to tedy zvládneme?

pokračovat... 👇

1) Řídká pozornost

Omezuje výpočet pozornosti na podmnožinu tokenů tím, že:

- Využití místní pozornosti (žetony se věnují pouze svým sousedům).

- Nechat model, aby se naučil, na které tokeny se má zaměřit.

To však má kompromis mezi výpočetní složitostí a výkonem.

Podobná myšlenka byla použita v ModernBERT.

→ Plná globální pozornost každou třetí vrstvu

→ Místní pozornost (128 žetonů) jinak

Výsledek:

- 16x větší délka sekvence

- Mnohem lepší výkon

- Nejefektivnější kódovač v oblasti paměti

Jednoduché, ale silné.

Zde je intuitivní vysvětlení převzaté z článku:

Představte si, že čtete knihu. U každé věty, kterou čtete, musíte si být plně vědomi celé zápletky, abyste pochopili většinu z ní (plnou globální pozornost)?

Nebo je dostatečné povědomí o aktuální kapitole (místní pozornost), pokud se občas zamyslíte nad jejím významem pro hlavní zápletku (globální pozornost)?

V drtivé většině případů je to to druhé.

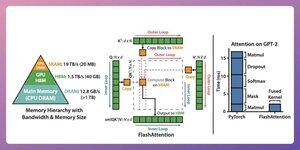

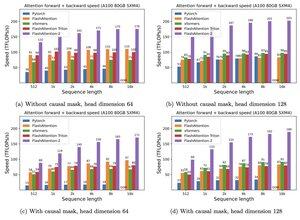

2) Blesková pozornost

Jedná se o rychlou a paměťově efektivní metodu, která si zachovává přesnost tradičních mechanismů pozornosti, tj. využívá globální pozornost, ale efektivně.

Celá myšlenka se točí kolem optimalizace pohybu dat v paměti GPU.

Pojďme to pochopit!

Některé podrobnosti o pozadí:

- Vlákno je nejmenší jednotka provádění.

- Několik vláken tvoří blok.

Také:

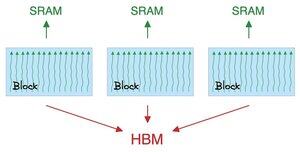

- Vlákna v bloku sdílejí rychlou (ale vzácnou) paměť zvanou SRAM.

- Všechny bloky sdílejí globální paměť zvanou HBM (hojná, ale pomalá).

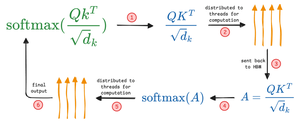

Zkontrolujte toto 👇

Pozornost přesouvá velké matice mezi SRAM a HBM:

Výpočet QK:

- rozdělovat matice do závitů

- vypočítat a

- odeslat produkt do HBM

Výpočet softmax:

- distribuovat produkt do vláken

- vypočítat a

- odeslat výstup do HBM

Tento postup opakujte pro všechny vrstvy.

Zkontrolujte toto 👇

Flash Attention zahrnuje optimalizace na úrovni hardwaru, při kterých využívá SRAM k ukládání mezivýsledků do mezipaměti.

Tímto způsobem snižuje nadbytečné pohyby a nabízí zrychlení až 7,6x oproti standardním metodám pozornosti.

Zkontrolujte toto 👇

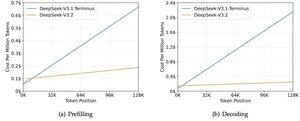

3) DeepSeek Sparse Attention (DSA)

Nový model DeepSeek V3.2 zavádí DeepSeek Sparse Attention (DSA), který snižuje složitost z O(L²) na O(Lk), kde je k pevně dané.

Jak to funguje:

Lehký Lightning Indexer hodnotí, které tokeny skutečně mají význam pro každý dotaz.

Malý počet hlav, běží v FP8, výpočetně levné.

Poté výběrový mechanismus získá pouze položky s klíčem a hodnotou v horní kategorii.

Klíčovým poznatkem je, že na dotaz je vybráno pouze 2048 tokenů, bez ohledu na délku kontextu.

Takže nákladné výpočty pozornosti probíhají na této malé podmnožině, nikoli na celé sekvenci 128K.

Při 128K kontextu klesají náklady na předvyplnění z ~$0,65 na ~$0,35 za milion tokenů. A Decoding klesá z ~$2.4 na ~$0.8.

A výkon zůstává stejný. Na některých dlouhodobých benchmarkech má V3.2 dokonce vyšší skóre.

Malá pozornost není nic nového. Ale zvládnout to, aniž by to ztratilo kvalitu, je těžké.

Jaké jsou další techniky pro zvýšení délky kontextu u LLM?

152,61K

Top

Hodnocení

Oblíbené