Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Estás en una entrevista para un científico investigador en OpenAI.

El entrevistador pregunta:

"¿Cómo ampliarías la longitud de contexto de un LLM de 2K a 128K tokens?"

Tú: "Ajustaré el modelo en documentos más largos con contexto de 128K."

Entrevista terminada.

Esto es lo que te perdiste:

Extender la ventana de contexto no se trata solo de matrices más grandes.

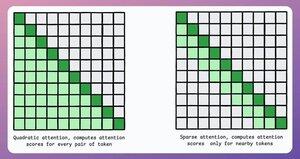

En un transformador tradicional, expandir tokens en 8 veces aumenta las necesidades de memoria en 64 veces debido a la complejidad cuadrática de la atención. ¡Consulte la imagen a continuación!

Entonces, ¿cómo lo gestionamos?

continuar... 👇

1) Atención escasa

Limita el cálculo de la atención a un subconjunto de tokens mediante:

- Usar la atención local (las fichas atienden solo a sus vecinos).

- Dejar que el modelo aprenda en qué tokens enfocarse.

Pero esto tiene una compensación entre la complejidad computacional y el rendimiento.

Una idea similar se utilizó en ModernBERT.

→ Atención global total cada tercera capa

→ Atención local (128 tokens) de lo contrario

Resultado:

- Longitud de secuencia 16 veces mayor

- Mucho mejor rendimiento

- Codificador más eficiente en memoria

Simple pero poderoso.

Aquí hay una explicación intuitiva tomada del artículo:

Imagínate leyendo un libro. Por cada oración que lees, ¿necesitas ser plenamente consciente de toda la trama para entender la mayor parte de ella (atención global completa)?

¿O es suficiente conciencia del capítulo actual (atención local), siempre y cuando de vez en cuando pienses en su importancia para la trama principal (atención global)?

En la gran mayoría de los casos, es lo último.

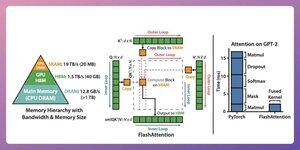

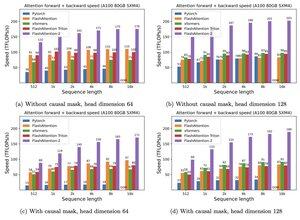

2) Atención flash

Se trata de un método rápido y eficiente en memoria que conserva la exactitud de los mecanismos de atención tradicionales, es decir, utiliza la atención global pero de forma eficiente.

Toda la idea gira en torno a la optimización del movimiento de datos dentro de la memoria de la GPU.

¡Entendamos!

Algunos detalles de fondo:

- Un hilo es la unidad de ejecución más pequeña.

- Varios hilos forman un bloque.

Además:

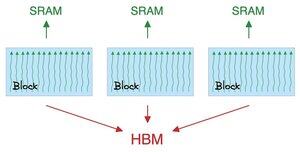

- Los subprocesos de un bloque comparten una memoria rápida (pero escasa) llamada SRAM.

- Todos los bloques comparten una memoria global llamada HBM (abundante pero lenta).

Mira esto 👇

La atención mueve grandes matrices entre SRAM y HBM:

Para calcular QK:

- distribuir matrices a los hilos

- calcular, y

- enviar el producto a HBM

Para calcular softmax:

- distribuir el producto a los hilos

- calcular, y

- enviar salida a HBM

Repita para todas las capas.

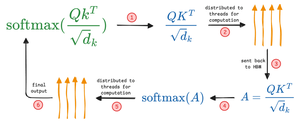

Mira esto 👇

La atención flash implica optimizaciones a nivel de hardware en las que utiliza SRAM para almacenar en caché los resultados intermedios.

De esta manera, reduce los movimientos redundantes, ofreciendo una velocidad de hasta 7,6 veces sobre los métodos de atención estándar.

Mira esto 👇

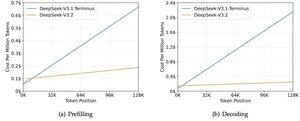

3) DeepSeek Atención Escasa (DSA)

El nuevo modelo V3.2 de DeepSeek introduce la Atención Escasa (DSA) de DeepSeek, que reduce la complejidad de O(L²) a O(Lk), donde k es fijo.

Cómo funciona:

Un indexador Lightning ligero puntua qué tokens realmente importan para cada consulta.

Pequeño número de cabezas, funciona en FP8, es computacionalmente barato.

Luego, un mecanismo de selección recupera solo las k entradas clave-valor superiores.

La idea clave es que solo se seleccionan 2048 tokens por consulta, independientemente de la longitud del contexto.

Así que el costoso cálculo de atención ocurre en este pequeño subconjunto, no en la secuencia completa de 128K.

En el contexto de 128K, los costes de pre-rellenado bajan de ~$0,65 a ~$0,35 por millón de tokens. Y la Decodificación baja de ~$2.4 a ~$0.8.

Y la actuación sigue igual. En algunos benchmarks de contexto largo, la V3.2 en realidad obtiene una puntuación más alta.

La poca atención no es nueva. Pero conseguir que funcione sin perder calidad es difícil.

¿Cuáles son otras técnicas para aumentar la longitud del contexto de los LLM?

152.61K

Populares

Ranking

Favoritas