المواضيع الرائجة

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

أنت في مقابلة مع عالم أبحاث في OpenAI.

يسأل المحاور:

"كيف توسع طول السياق لنموذج اللغة الكبير من 2K إلى 128K رمز؟"

أنت: "سأضبط النموذج بدقة على وثائق أطول مع سياق 128 كيلوبايت."

انتهت المقابلة.

إليك ما فاتك:

لا يقتصر توسيع نافذة السياق على المصفوفات الأكبر فقط.

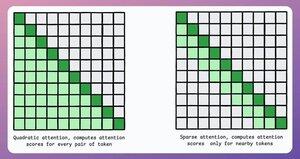

في المحول التقليدي ، يؤدي توسيع الرموز المميزة بمقدار 8x إلى زيادة احتياجات الذاكرة بمقدار 64x بسبب التعقيد التربيعي للانتباه. راجع الصورة أدناه!

إذن ، كيف ندير ذلك؟

استمر... 👇

1) اهتمام متناثر

يحد من حساب الانتباه إلى مجموعة فرعية من الرموز من خلال:

- استخدام الاهتمام المحلي (الرموز المميزة لا تهتم إلا بجيرانها).

- السماح للنموذج بمعرفة الرموز المميزة التي يجب التركيز عليها.

لكن هذا له مقايضة بين التعقيد الحسابي والأداء.

تم استخدام فكرة مشابهة في ModernBERT.

→ انتباه عالمي كامل كل طبقة ثالثة

→ الاهتمام المحلي (128 رمزا) بخلاف ذلك

نتيجة:

- طول تسلسل أكبر ب16 مرة

- أداء أفضل بكثير

- أكثر مشفر كفاءة في الذاكرة

بسيط لكنه قوي.

إليك شرح بديهي مأخوذ من الورقة:

تخيل نفسك وأنت تقرأ كتابا. لكل جملة تقرأها ، هل تحتاج إلى أن تكون على دراية كاملة بالحبكة بأكملها لفهم معظمها (الاهتمام العالمي الكامل)؟

أم أن الوعي بالفصل الحالي كاف (الاهتمام المحلي) ، طالما أنك تفكر أحيانا في أهميته بالنسبة للحبكة الرئيسية (الاهتمام العالمي)؟

في الغالبية العظمى من الحالات ، يكون هذا هو الأخير.

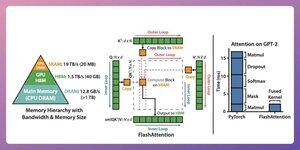

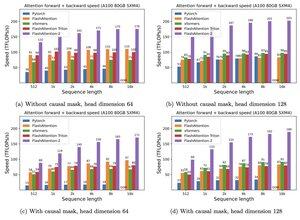

2) فلاش الانتباه

هذه طريقة سريعة وفعالة للذاكرة تحتفظ بدقة آليات الانتباه التقليدية ، أي أنها تستخدم اهتماما عالميا ولكن بكفاءة.

تدور الفكرة برمتها حول تحسين حركة البيانات داخل ذاكرة GPU.

دعونا نفهم!

بعض تفاصيل الخلفية:

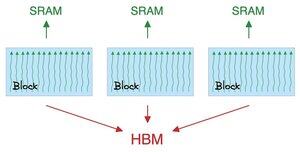

- الخيط هو أصغر وحدة تنفيذ.

- عدة خيوط تشكل كتلة.

أيضًا:

- تشترك مؤشرات الترابط في كتلة في ذاكرة سريعة (ولكنها نادرة) تسمى SRAM.

- تشترك جميع الكتل في ذاكرة عالمية تسمى HBM (وفيرة ولكنها بطيئة).

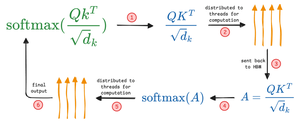

تحقق من هذا 👇

يحرك الانتباه المصفوفات الكبيرة بين SRAM و HBM:

لحساب QK:

- توزيع المصفوفات على الخيوط

- الحوسبة، و

- أرسل المنتج إلى HBM

لحساب softmax:

- توزيع المنتج على المواضيع

- الحوسبة، و

- إرسال الإخراج إلى HBM

كرر لجميع الطبقات.

تحقق من هذا 👇

يتضمن انتباه الفلاش تحسينات على مستوى الأجهزة حيث يستخدم SRAM لتخزين النتائج الوسيطة مؤقتا.

بهذه الطريقة ، يقلل من الحركات الزائدة عن الحاجة ، مما يوفر سرعة تصل إلى 7.6 مرة مقارنة بطرق الانتباه القياسية.

تحقق من هذا 👇

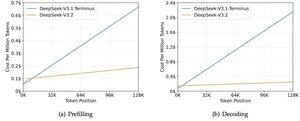

3) البحث العميق عن الاهتمام المتناثر (DSA)

يقدم نموذج V3.2 الجديد من DeepSeek نظام DeepSeek Sparse Attention (DSA)، الذي يخفض التعقيد من O(L²) إلى O(Lk)، حيث يكون k ثابتا.

كيف يعمل:

مؤشر Lightning Indexer خفيف الوزن يحدد أي الرموز مهمة فعلا لكل استفسار.

عدد قليل من الرؤوس، يعمل في FP8، ورخيص حسابيا.

ثم تقوم آلية الاختيار باسترجاع فقط مدخلات قيمة المفتاح الأعلى-k.

النقطة الأساسية هي أن 2048 رمزا فقط يتم اختيارها لكل استفسار، بغض النظر عن طول السياق.

لذا فإن حساب الانتباه المكلف يحدث على هذه المجموعة الصغيرة، وليس على تسلسل 128K الكامل.

عند سياق 128 ألف، تنخفض تكاليف التعبئة المسبق من ~$0.65 إلى ~$0.35 لكل مليون رمز. وينخفض فك التشفير من ~$2.4 إلى ~$0.8.

ويبقى الأداء كما هو. في بعض معايير السياق الطويل، يحصل V3.2 على درجات أعلى فعليا.

الاهتمام المحدود ليس جديدا. لكن جعلها تعمل دون فقدان الجودة أمر صعب.

ما هي بعض التقنيات الأخرى لزيادة طول السياق في نماذج اللغة الكبيرة؟

152.6K

الأفضل

المُتصدِّرة

التطبيقات المفضلة