Topik trending

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Anda sedang dalam wawancara Ilmuwan Riset di OpenAI.

Pewawancara bertanya:

"Bagaimana Anda memperluas panjang konteks LLM dari 2K menjadi 128K token?"

Anda: "Saya akan menyempurnakan model pada dokumen yang lebih panjang dengan konteks 128K."

Wawancara selesai.

Inilah yang Anda lewatkan:

Memperluas jendela konteks bukan hanya tentang matriks yang lebih besar.

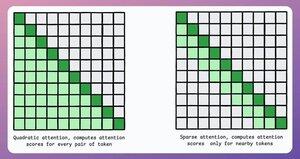

Dalam transformator tradisional, memperluas token sebesar 8x meningkatkan kebutuhan memori sebesar 64x karena kompleksitas perhatian kuadrat. Lihat gambar di bawah ini!

Jadi, bagaimana kita mengelolanya?

terus... 👇

1) Perhatian Jarang

Ini membatasi perhitungan perhatian ke subset token dengan:

- Menggunakan perhatian lokal (token hanya melayani tetangga mereka).

- Membiarkan model mempelajari token mana yang harus difokuskan.

Tetapi ini memiliki trade-off antara kompleksitas komputasi dan kinerja.

Ide serupa digunakan di ModernBERT.

→ Perhatian global penuh setiap lapisan ke-3

→ Perhatian lokal (128 token) sebaliknya

Hasil:

- Panjang urutan 16x lebih besar

- Kinerja yang jauh lebih baik

- Encoder paling hemat memori

Sederhana namun kuat.

Berikut adalah penjelasan intuitif yang diambil dari makalah tersebut:

Bayangkan diri Anda membaca buku. Untuk setiap kalimat yang Anda baca, apakah Anda perlu sepenuhnya menyadari seluruh plot untuk memahami sebagian besar (perhatian global penuh)?

Atau apakah kesadaran akan bab saat ini cukup (perhatian lokal), selama Anda sesekali memikirkan kembali signifikansinya terhadap plot utama (perhatian global)?

Dalam sebagian besar kasus, itu adalah yang terakhir.

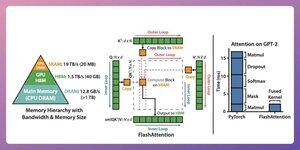

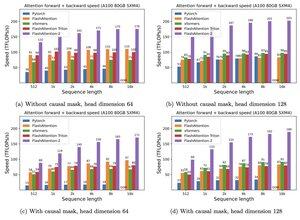

2) Perhatian Flash

Ini adalah metode yang cepat dan hemat memori yang mempertahankan ketepatan mekanisme perhatian tradisional, yaitu menggunakan perhatian global tetapi secara efisien.

Seluruh ide berkisar pada pengoptimalan pergerakan data dalam memori GPU.

Mari kita pahami!

Beberapa detail latar belakang:

- Utas adalah unit eksekusi terkecil.

- Beberapa utas membentuk balok.

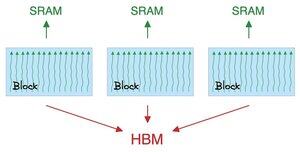

Juga:

- Utas dalam blok berbagi memori cepat (tetapi langka) yang disebut SRAM.

- Semua blok berbagi memori global yang disebut HBM (melimpah tetapi lambat).

Periksa ini 👇

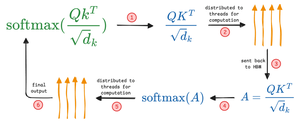

Perhatian memindahkan matriks besar antara SRAM dan HBM:

Untuk menghitung QK:

- mendistribusikan matriks ke utas

- komputasi, dan

- kirim produk ke HBM

Untuk menghitung softmax:

- mendistribusikan produk ke utas

- komputasi, dan

- kirim output ke HBM

Ulangi untuk semua lapisan.

Periksa ini 👇

Perhatian flash melibatkan pengoptimalan tingkat perangkat keras di mana ia menggunakan SRAM untuk menyimpan hasil perantara dalam cache.

Dengan cara ini, ini mengurangi gerakan yang berlebihan, menawarkan kecepatan hingga 7,6x dibandingkan metode perhatian standar.

Periksa ini 👇

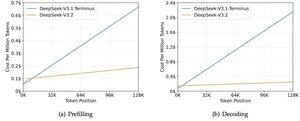

3) DeepSeek Perhatian Jarang (DSA)

Model V3.2 baru DeepSeek memperkenalkan DeepSeek Sparse Attention (DSA), yang menurunkan kompleksitas dari O(L²) ke O(Lk), di mana k diperbaiki.

Cara kerjanya:

Lightning Indexer yang ringan menilai token mana yang benar-benar penting untuk setiap kueri.

Sejumlah kecil kepala, berjalan di FP8, komputasi murah.

Kemudian mekanisme pemilihan hanya mengambil entri nilai kunci k teratas.

Wawasan utamanya adalah bahwa hanya 2048 token yang dipilih per kueri, terlepas dari panjang konteksnya.

Jadi perhitungan perhatian yang mahal terjadi pada subset kecil ini, bukan urutan 128K penuh.

Pada konteks 128K, biaya pra-pengisian turun dari ~$0,65 menjadi ~$0,35 per juta token. Dan Decoding turun dari ~$2,4 menjadi ~$0,8.

Dan kinerjanya tetap sama. Pada beberapa tolok ukur konteks panjang, V3.2 sebenarnya mendapat skor lebih tinggi.

Perhatian yang jarang bukanlah hal baru. Tetapi membuatnya bekerja tanpa kehilangan kualitas itu sulit.

Apa saja teknik lain untuk meningkatkan panjang konteks LLM?

152,61K

Teratas

Peringkat

Favorit