Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

LLM als Richter ist zu einer dominierenden Methode geworden, um zu bewerten, wie gut ein Modell eine Aufgabe löst, da es ohne einen Testdatensatz funktioniert und Fälle behandelt, in denen Antworten nicht eindeutig sind.

Aber trotz der weit verbreiteten Nutzung sind fast alle berichteten Ergebnisse stark verzerrt.

Ich freue mich, unser Preprint darüber zu teilen, wie man LLM richtig als Richter verwendet.

🧵

===

Wie verwenden die Leute LLM tatsächlich als Richter?

Die meisten Menschen verwenden das LLM einfach als Evaluator und berichten über die empirische Wahrscheinlichkeit, dass das LLM sagt, die Antwort sieht korrekt aus.

Wenn das LLM perfekt ist, funktioniert das gut und liefert einen unverzerrten Schätzer.

Wenn das LLM nicht perfekt ist, bricht das zusammen.

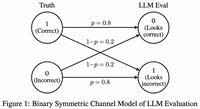

Betrachten Sie einen Fall, in dem das LLM 80 Prozent der Zeit korrekt bewertet.

Genauer gesagt, wenn die Antwort korrekt ist, sagt das LLM mit 80 Prozent Wahrscheinlichkeit: "Das sieht korrekt aus", und dieselben 80 Prozent gelten, wenn die Antwort tatsächlich inkorrekt ist.

In dieser Situation sollten Sie die empirische Wahrscheinlichkeit nicht berichten, da sie verzerrt ist. Warum?

Lassen Sie die wahre Wahrscheinlichkeit, dass das getestete Modell korrekt ist, p sein.

Dann ist die empirische Wahrscheinlichkeit, dass das LLM "korrekt" sagt (= q),

q = 0.8p + 0.2(1 - p) = 0.2 + 0.6p

Der unverzerrte Schätzer sollte also sein...

Top

Ranking

Favoriten