Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

LLM som dommer har blitt en dominerende måte å evaluere hvor god en modell er til å løse en oppgave, siden den fungerer uten testsett og håndterer tilfeller der svarene ikke er unike.

Men til tross for hvor mye dette brukes, er nesten alle rapporterte resultater svært partiske.

Gleder meg til å dele vår preprint om hvordan man riktig bruker LLM som dommer.

🧵

===

Så hvordan bruker folk egentlig LLM som dommer?

De fleste bruker bare LLM-en som en evaluator og rapporterer den empiriske sannsynligheten for at LLM-en sier svaret ser riktig ut.

Når LLM-en er perfekt, fungerer dette fint og gir en upartisk estimator.

Hvis LLM-en ikke er perfekt, brytes dette.

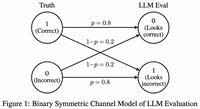

Tenk på et tilfelle der LLM-en evaluerer korrekt 80 prosent av gangene.

Mer spesifikt, hvis svaret er riktig, sier LLM-en «dette ser riktig ut» med 80 prosent sannsynlighet, og de samme 80 prosentene gjelder når svaret faktisk er feil.

I denne situasjonen bør du ikke rapportere den empiriske sannsynligheten, fordi den er skjev. Hvorfor?

La den sanne sannsynligheten for at den testede modellen er korrekt være p.

Da er den empiriske sannsynligheten for at LLM-en sier «korrekt» (= q)

q = 0,8p + 0,2(1 - p) = 0,2 + 0,6p

Så det upartiske estimatet bør være...

Topp

Rangering

Favoritter