トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

LLMは、テストセットなしで機能し、答えが一意でない場合にも対応できるため、審査員としてのモデルの課題解決能力を評価する主要な方法となっています。

しかし、この方法が広く使われているにもかかわらず、報告されたほとんどの結果は非常に偏っています。

裁判官としてLLMを正しく活用する方法についてのプレプリントを共有できることを楽しみにしています。

🧵

===

では、実際に人々は裁判官としてどのようにLLMを活用しているのでしょうか?

ほとんどの人はLLMを評価者として使い、LLMが答えが正しいと言う経験的な確率を報告します。

LLMが完璧であれば問題なく機能し、偏りのない推定量が得られます。

LLMが完璧でなければ、このシステムは壊れます。

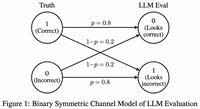

LLMが80%の確率で正しく評価するケースを考えてみましょう。

より具体的には、答えが正解であればLLMは80%の確率で「これは正しい」と言い、実際に誤りでも同じ80%の確率が適用されます。

この場合、経験的確率は偏っているため報告すべきではありません。なぜでしょうか。

テストモデルが正しい真の確率をpとします。

このとき、LLMが「正しい」と言う経験的確率(=q)は次の通りです

q = 0.8p + 0.2(1 - p) = 0.2 + 0.6p

したがって、偏りのない推定値は次のようになります...

トップ

ランキング

お気に入り