Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

LLM в качестве судьи стал доминирующим способом оценки того, насколько хорошо модель решает задачу, поскольку он работает без тестового набора и обрабатывает случаи, когда ответы не уникальны.

Но, несмотря на то, как широко это используется, почти все сообщенные результаты сильно предвзяты.

С нетерпением ждем возможности поделиться нашим препринтом о том, как правильно использовать LLM в качестве судьи.

🧵

===

Так как же люди на самом деле используют LLM в качестве судьи?

Большинство людей просто используют LLM в качестве оценщика и сообщают эмпирическую вероятность того, что LLM говорит, что ответ выглядит правильным.

Когда LLM идеален, это работает нормально и дает непредвзятый оценщик.

Если LLM не идеален, это ломается.

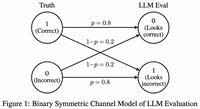

Рассмотрим случай, когда LLM оценивает правильно 80 процентов времени.

Более конкретно, если ответ правильный, LLM говорит "это выглядит правильно" с вероятностью 80 процентов, и та же вероятность 80 процентов применяется, когда ответ на самом деле неправильный.

В этой ситуации вы не должны сообщать эмпирическую вероятность, потому что она предвзята. Почему?

Пусть истинная вероятность того, что протестированная модель правильна, равна p.

Тогда эмпирическая вероятность того, что LLM говорит "правильно" (= q) равна

q = 0.8p + 0.2(1 - p) = 0.2 + 0.6p

Таким образом, непредвзятая оценка должна быть...

Топ

Рейтинг

Избранное