Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

PUMP Der öffentliche Verkauf ist beendet. Ursprünglich hatte ich auch einen großen Betrag bei Bybit, nur die Hälfte auf der Blockchain, am Ende hat nur die Blockchain-Transaktion funktioniert, zum Glück habe ich nicht vorzeitig abgesichert...

Übrigens diskutieren in letzter Zeit viele im AI-Community über VLA (Vision‑Language‑Action).

Ich habe speziell untersucht, ob es auf der Blockchain-Projekte gibt, die sich mit VLA beschäftigen, und habe das Projekt CodecFlow @Codecopenflow gesehen und ein wenig gekauft.

== Was macht das CodecFlow-Projekt? ==

Eine kurze Einführung in VLA: VLA ist eine Modellarchitektur, die es AI ermöglicht, nicht nur "reden" zu können, sondern auch "handeln" zu können.

Traditionelle LLMs (wie GPT) können nur Sprache verstehen und Vorschläge machen, aber sie können nicht selbst handeln, nicht auf dem Bildschirm klicken und keine Objekte greifen.

Das VLA-Modell bedeutet, dass drei Hauptfähigkeiten integriert sind:

1. Vision (Sicht): Verstehen von Bildern, Screenshots, Kameraeingaben oder Sensordaten.

2. Language (Sprache): Verstehen von natürlichen Sprachbefehlen der Menschen.

3. Action (Aktion): Erzeugen von ausführbaren Befehlen, wie Mausklicks, Tastatureingaben und Steuerung von Roboterarmen.

CodecFlow arbeitet an der Blockchain-VLA, alle Abläufe können auch auf der Blockchain gespeichert werden, sind prüfbar, verifizierbar und abgerechnet.

Kurz gesagt, es ist die grundlegende Infrastruktur für "AI-Roboter".

== Warum achte ich besonders auf dieses Projekt? ==

Ich habe festgestellt, dass ihre Entwickler die Hauptbeiträger des heißesten Open-Source-Projekts im VLA-Bereich, LeRobot, sind!

LeRobot ist die Top-Basis in der Open-Source-Welt für den Aufbau von VLA-Modellen, einschließlich SmolVLA, das auf Laptops läuft.

Das bedeutet, dass dieses Team wirklich die VLA-Architektur und Roboter versteht.

Ich sehe, dass sie weiterhin aufbauen, der Preis der Münze stabil steigt, ich persönlich bin sehr optimistisch über den VLA-Sektor, und insgesamt gesehen ist VLA zusammen mit Robotern in der Marktlandschaft definitiv die Zukunft.

• Web2-Giganten (Google, Meta, Tesla) haben derzeit alle Ressourcen in VLA & Roboterschulung investiert;

• Web3-Projekte, die in der Lage sind, Aufgaben auszuführen, sind im VLA-Anwendungsbereich noch sehr rar.

• VLA hat die Möglichkeit, in Szenarien wie DePIN, Web-Automatisierung und Blockchain-AI-Agenten enorme Werte zu schaffen.

CA: 69LjZUUzxj3Cb3Fxeo1X4QpYEQTboApkhXTysPpbpump

Immer DYOR.

26. Juni 2025

Was ist ein $CODEC Operator?

Es ist der Punkt, an dem Vision-Language-Action-Modelle KI endlich nützlich für echte Arbeit machen.

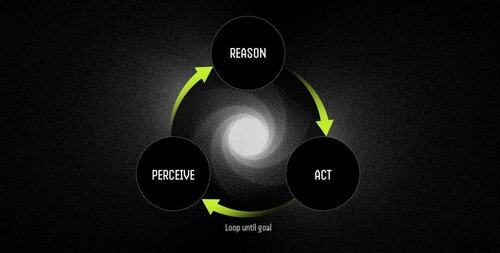

Ein Operator ist ein autonomer Software-Agent, der von VLA-Modellen angetrieben wird und Aufgaben durch einen kontinuierlichen Wahrnehmen-Denken-Handeln-Zyklus ausführt.

LLMs können brillant denken und sprechen, aber sie können nichts zeigen, klicken oder greifen. Sie sind reine Denkmaschinen ohne jegliche Verankerung in der physischen Welt.

VLAs kombinieren visuelle Wahrnehmung, Sprachverständnis und strukturierte Aktionsausgaben in einem einzigen Vorwärtsdurchlauf. Während ein LLM beschreibt, was geschehen sollte, sorgt ein VLA-Modell tatsächlich dafür, dass es geschieht, indem es Koordinaten, Steuersignale und ausführbare Befehle ausgibt.

Der Workflow des Operators ist:

- Wahrnehmung: erfasst Screenshots, Kamerafeeds oder Sensordaten.

- Denken: verarbeitet Beobachtungen zusammen mit Anweisungen in natürlicher Sprache unter Verwendung des VLA-Modells.

- Handlung: führt Entscheidungen durch UI-Interaktionen oder Hardwaresteuerung aus – alles in einem kontinuierlichen Loop.

Beispiele: LLM vs. Operator, der von VLA-Modell angetrieben wird

Ein Meeting planen

LLM: Gibt eine detaillierte Erklärung des Kalender-Managements und der Schritte zur Planung eines Meetings.

Operator mit VLA-Modell:

- Erfasst den Desktop des Benutzers.

- Identifiziert die Kalenderanwendung (z. B. Outlook, Google Kalender).

- Navigiert zu Donnerstag, erstellt ein Meeting um 14 Uhr und fügt Teilnehmer hinzu.

- Passt sich automatisch an Änderungen der Benutzeroberfläche an.

Robotik: Objekte sortieren

LLM: Generiert präzise schriftliche Anweisungen zum Sortieren von Objekten, wie z. B. das Identifizieren und Organisieren roter Komponenten.

Operator mit VLA-Modell:

- Beobachtet den Arbeitsplatz in Echtzeit.

- Identifiziert rote Komponenten unter gemischten Objekten.

- Plant kollisionfreie Trajektorien für einen Roboterarm.

- Führt Pick-and-Place-Operationen aus und passt sich dynamisch an neue Positionen und Orientierungen an.

VLA-Modelle überbrücken endlich die Kluft zwischen KI, die über die Welt nachdenken kann, und KI, die sie tatsächlich verändern kann. Sie verwandeln Automatisierung von fragilen Regelbefolgungen in adaptive Problemlösungen – intelligente Arbeiter.

"Traditionelle Skripte brechen, wenn sich die Umgebung ändert, aber Operatoren nutzen visuelles Verständnis, um sich in Echtzeit anzupassen und Ausnahmen zu behandeln, anstatt bei ihnen abzustürzen."

10,74K

Top

Ranking

Favoriten