热门话题

#

Bonk 生态迷因币展现强韧势头

#

有消息称 Pump.fun 计划 40 亿估值发币,引发市场猜测

#

Solana 新代币发射平台 Boop.Fun 风头正劲

PUMP 公售结束了,原本我也是大额在Bybit,链上只放1/2,最后只有链上的打成功,还好没有提前套保...

话说最近AI社群上很多人在讨论 VLA(Vision-Language-Action)

特别去研究了一下链上项目有没有人在做VLA相关的,看到了这个CodecFlow@Codecopenflow的项目,买了一点。

== CodecFlow这项目在干嘛 ==

简单介绍一下VLA,VLA 是一种让 AI 不只「能说」,而是「能做」的模型架构。

传统的 LLM(像 GPT)只能理解语言、提供建议,但它不会动手作、不会点击画面、不会抓取物体。

VLA 模型的意思就是整合了三大能力:

1. Vision(视觉):看得懂画面、截图、摄像机输入或传感器数据

2. Language(语言):理解人类的自然语言指令

3. Action(动作):产生可执行的指令,如鼠标点击、键盘输入、控制机械手臂

CodecFlow 他们就是在做链上的VLA,所有作流程还可以上链,可审计、可验证、可结算。

简单来说就是 “AI 机器人” 的基础架构。

== 为什么我会特别注意这项目? ==

我发现他们的开发者是 VLA 领域最火开源项目 LeRobot 的核心贡献者!

LeRobot 就是开源界打造 VLA 模型的顶级基地,包含了 SmolVLA 等能在笔电上跑的轻量 VLA。

代表这团队是真的懂VlA架构懂Robot的。

我看他们也持续的在建设,币价也稳定的在上涨,我自己是很看好VLA赛道,而且从整体趋势来看VLA跟机器人在市场上确实是未来。

• Web2 巨头(Google、Meta、Tesla)目前已全力投入 VLA & 机器人训练;

• Web3 项目好少有能执行任务的 VLA 应用还非常稀缺

• VLA 有机会在 DePIN、Web Automation、链上 AI Agent 执行等场景发挥巨大价值。

CA:69LjZUUzxj3Cb3Fxeo1X4QpYEQTboApkhXTysPpbpump

Always DYOR。

2025年6月26日

什么是 $CODEC 操作员?

这是视觉-语言-行动模型最终使人工智能在实际工作中变得有用的地方。

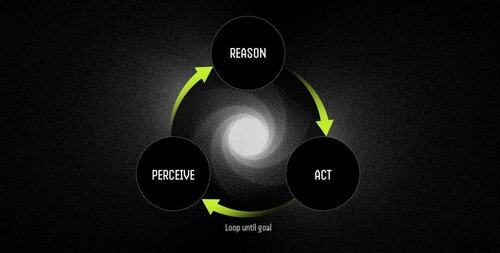

操作员是一个由 VLA 模型驱动的自主软件代理,通过持续的感知-推理-行动循环执行任务。

大型语言模型(LLMs)可以出色地思考和交流,但它们无法指向、点击或抓取任何东西。它们是纯粹的推理引擎,与物理世界没有任何联系。

视觉-语言-行动(VLA)模型在单次前向传递中结合了视觉感知、语言理解和结构化的行动输出。当 LLM 描述应该发生什么时,VLA 模型实际上通过发出坐标、控制信号和可执行命令来实现它。

操作员工作流程是:

- 感知:捕获屏幕截图、摄像头视频或传感器数据。

- 推理:使用 VLA 模型处理观察结果和自然语言指令。

- 行动:通过用户界面交互或硬件控制执行决策——所有这些都在一个连续的循环中。

示例:LLM 与 VLA 模型驱动的操作员

安排会议

LLM:提供关于日历管理的详细说明,概述安排会议的步骤。

VLA 模型的操作员:

- 捕获用户的桌面。

- 识别日历应用程序(例如,Outlook、Google 日历)。

- 导航到星期四,创建下午 2 点的会议,并添加与会者。

- 自动适应用户界面的变化。

机器人技术:分类物体

LLM:生成分类物体的精确书面指令,例如识别和组织红色组件。

VLA 模型的操作员:

- 实时观察工作空间。

- 在混合物体中识别红色组件。

- 为机器人手臂规划无碰撞轨迹。

- 执行抓取和放置操作,动态调整到新的位置和方向。

VLA 模型最终弥合了能够推理世界的人工智能与能够实际改变世界的人工智能之间的差距。它们将自动化从脆弱的规则遵循转变为自适应问题解决——智能工作者。

“传统脚本在环境变化时会崩溃,但操作员利用视觉理解实时适应,处理异常而不是崩溃。”

10.7K

热门

排行

收藏