熱門話題

#

Bonk 生態迷因幣展現強韌勢頭

#

有消息稱 Pump.fun 計劃 40 億估值發幣,引發市場猜測

#

Solana 新代幣發射平臺 Boop.Fun 風頭正勁

什麼是 $CODEC 運算符?

這是視覺-語言-行動模型最終使 AI 在實際工作中發揮作用的地方。

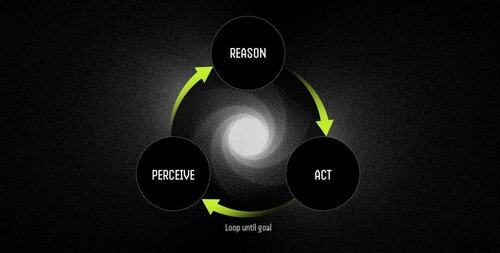

Operator 是由 VLA 模型提供支援的自主軟體代理,它通過連續的感知-推理-行為迴圈來執行任務。

LLM 可以出色地思考和交談,但他們不能指向、點擊或抓取任何東西。它們是純粹的推理引擎,在物理世界中沒有任何基礎。

VLA 將視覺感知、語言理解和結構化動作輸出結合在單個前向傳遞中。LLM 描述了應該發生的事情,而 VLA 模型實際上是通過發出座標、控制信號和可執行命令來實現的。

Operator 工作流為:

- 感知:捕獲螢幕截圖、攝像頭源或感測器數據。

- 推理:使用 VLA 模型處理觀察結果和自然語言指令。

-作:通過UI交互或硬體控制執行決策 - 所有這些都在一個連續迴圈中完成。

示例:LLM 與 Operator Powered by VLA 模型

安排會議

LLM:提供日曆管理的詳細說明,概述安排會議的步驟。

具有 VLA 模型的運算子:

- 捕獲使用者的桌面。

- 標識日曆應用程式(例如 Outlook、Google 日曆)。

- 導航到星期四,在下午 2 點創建會議,並添加出席者。

- 自動適應使用者介面更改。

機器人:對對象進行排序

LLM:生成用於對對對象進行排序的精確書面說明,例如識別和組織紅色元件。

具有 VLA 模型的運算子:

- 實時觀察工作區。

- 識別混合物件中的紅色分量。

- 為機械臂規劃無碰撞軌跡。

- 執行拾取和放置作,動態調整到新的位置和方向。

VLA 模型最終彌合了可以推理世界的 AI 和可以真正改變世界的 AI 之間的差距。它們將自動化從脆弱的規則遵循轉變為適應性問題解決能力 - 智能員工。

“當環境發生變化時,傳統腳本會中斷,但 Operator 使用視覺理解來實時適應,處理異常而不是崩潰。”

1.34K

熱門

排行

收藏