トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

$CODECオペレーターとは?

そこで、Vision-Language-ActionモデルがついにAIを実際の仕事に役立てるようになりました。

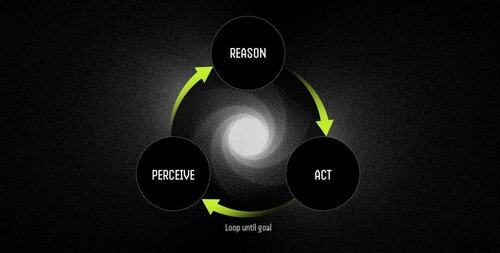

Operator は、VLA モデルを搭載した自律的なソフトウェア エージェントであり、継続的な知覚-理由-行動のサイクルを通じてタスクを実行します。

LLMは見事に考え、話すことができますが、何かを指差したり、クリックしたり、つかんだりすることはできません。彼らは純粋な推論エンジンであり、物理世界での接地はゼロです。

VLA は、視覚、言語理解、構造化されたアクション出力を 1 つのフォワード パスに組み合わせます。LLM は何が起こるべきかを記述しますが、VLA モデルは実際には座標、制御信号、および実行可能コマンドを出力することでそれを実現します。

Operator ワークフローは次のとおりです。

- 知覚:スクリーンショット、カメラフィード、またはセンサーデータをキャプチャします。

- 推論:VLAモデルを使用して、自然言語命令と並行して観測値を処理します。

- アクション: UI インタラクションやハードウェア制御を通じて、すべて 1 つの連続ループで意思決定を実行します。

例: LLM と VLA モデルによる演算子の比較

ミーティングのスケジュール

LLM: カレンダー管理の詳細な説明を提供し、会議をスケジュールする手順を概説します。

VLAモデルのオペレーター:

- ユーザーのデスクトップをキャプチャします。

- カレンダーアプリケーション(Outlook、Googleカレンダーなど)を識別します。

- 木曜日に移動し、午後 2 時にミーティングを作成し、出席者を追加します。

- ユーザーインターフェースの変更に自動的に適応します。

ロボティクス:オブジェクトの並べ替え

LLM:赤いコンポーネントの識別や整理など、オブジェクトを並べ替えるための正確な書面による指示を生成します。

VLAモデルのオペレーター:

- ワークスペースをリアルタイムで観察します。

- 混合オブジェクト間の赤い成分を識別します。

- ロボットアームの衝突のない軌道を計画します。

- ピックアンドプレース操作を実行し、新しい位置と向きに動的に調整します。

VLAモデルは、世界について推論できるAIと、実際に世界を変えることができるAIとの間のギャップをついに埋めます。彼らは、自動化を脆弱なルール追従から適応型の問題解決、つまりインテリジェントな労働者に変えるものです。

「従来のスクリプトは環境が変化すると壊れますが、オペレーターは視覚的な理解を使用してリアルタイムで適応し、例外をクラッシュさせるのではなく処理します。」

1.35K

トップ

ランキング

お気に入り