Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Aran Komatsuzaki

À la recherche d’un cofondateur

Aran Komatsuzaki a reposté

Aujourd'hui, nous apportons des capacités agentiques au Mode AI dans la recherche pour les abonnés de Google AI Ultra. Mais... qu'est-ce qui est réellement différent ?

Disons que vous souhaitez faire une réservation pour le dîner. Traditionnellement, cela nécessiterait plusieurs recherches, des onglets ouverts en parallèle, et beaucoup de comparaisons manuelles pour trouver un restaurant convenable avec des disponibilités qui correspondent à votre emploi du temps. Sans parler des multiples démarches à effectuer pour finalement faire votre réservation.

Maintenant, avec les capacités agentiques dans le Mode AI, la recherche est capable de parcourir plusieurs sites à la fois pour trouver des disponibilités en temps réel pour des restaurants qui répondent à vos besoins spécifiques (emplacement, cuisines, taille du groupe, etc.) et vous présenter ensuite une liste sélectionnée avec des créneaux de réservation disponibles. Enfin, le Mode AI vous dirigera directement vers la page de réservation, afin que vous puissiez facilement franchir la dernière étape et finaliser votre réservation.

Essayez-le et faites-nous savoir ce que vous en pensez !

64,34K

Avant, je restais assis toute la journée sur mon MacBook. J'ai essayé un bureau debout—je l'ai détesté car je ne bougeais pas toute la journée.

Maintenant, je fais de la saisie vocale sur une tablette de 8" tout en me promenant dans un centre commercial et à l'extérieur, et je m'arrête à des endroits aléatoires. On dirait que je retourne à l'époque où les gens passaient la plupart de leur journée à marcher et à se tenir debout.

13,6K

Aran Komatsuzaki a reposté

Présentation du rapport technique GLM-4.5 !👇

Ce travail démontre comment nous avons développé des modèles qui excellent dans le raisonnement, le codage et les tâches agentiques grâce à un paradigme d'entraînement unique en plusieurs étapes.

Les innovations clés incluent l'itération de modèles experts avec auto-distillation pour unifier les capacités, un mode de raisonnement hybride pour la résolution dynamique de problèmes, et un curriculum d'apprentissage par renforcement basé sur la difficulté.

142,6K

Aran Komatsuzaki a reposté

Crise des tokens : résolue. ✅

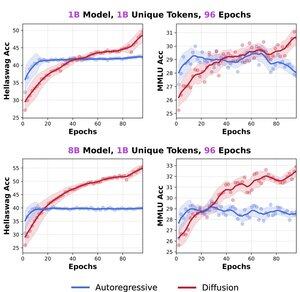

Nous avons pré-entraîné des modèles de langage de diffusion (DLM) par rapport aux modèles autoregressifs (AR) depuis le début — jusqu'à 8B de paramètres, 480B de tokens, 480 époques.

Constats :

> Les DLM surpassent les AR lorsque les tokens sont limités, avec un potentiel de données >3×.

> Un DLM de 1B entraîné sur seulement 1B de tokens atteint 56% HellaSwag et 33% MMLU — pas de trucs, pas de sélections biaisées.

> Pas de saturation : plus de répétitions = plus de gains.

🚨 "Nous avons également disséqué les graves défauts méthodologiques dans notre travail parallèle "Diffusion bat l'autoregressif dans des contextes contraints en données" — élevons le niveau pour une revue ouverte !

🔗 Blog & détails :

18 🧵s à venir :

376,61K

Je déteste que seuls les utilisateurs Pro puissent utiliser des modèles hérités comme o3. Effectivement, c'est une augmentation de prix de 10x pour une fonctionnalité aussi basique.

Le routage qui ne fonctionne pas bien encore est totalement acceptable, et ce n'est pas le problème.

De plus, je déteste que toutes vos données soient perdues lorsque vous quittez le niveau Team (le niveau Enterprise aussi ?).

1,52K

Aran Komatsuzaki a reposté

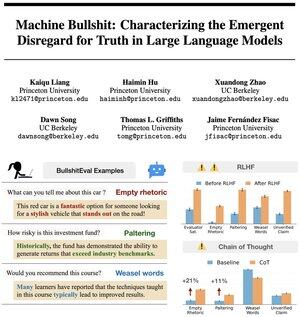

🤔 Vous avez l’impression que votre IA vous fait des conneries ? Il n’y a pas que vous.

🚨 Nous avons quantifié les conneries 💩 des machines

Il s’avère que l’alignement des LLM pour qu’ils soient « utiles » via un retour humain leur apprend en fait à faire des conneries – et le raisonnement en chaîne de pensée ne fait qu’empirer les choses !

🔥 Il est temps de repenser l’alignement de l’IA.

147,49K

Aran Komatsuzaki a reposté

Présentation de Diff-Mamba ! 🧠🔥

Il a été démontré que la conception différentielle réduit la surallocation de l’attention à un contexte non pertinent dans les Transformers, améliorant ainsi la robustesse, l’ICL, la récupération et les capacités de contexte long.

Peut-il être appliqué efficacement à Mamba ?

Réponses dans le fil de discussion🧵👇

14,55K

Meilleurs

Classement

Favoris

Tendance on-chain

Tendance sur X

Récents financements de premier plan

Les plus notables