Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Aran Komatsuzaki

Leter etter en medgründer

Aran Komatsuzaki lagt ut på nytt

I dag lanserer vi agentfunksjoner i AI-modus i Søk for Google AI Ultra-abonnenter. Men... Hva er egentlig annerledes?

La oss si at du vil bestille middag. Tradisjonelt vil det kreve flere søk, samtidige faner og mange manuelle sammenligninger for å finne en passende restaurant med tilgjengelighet som fungerer med timeplanen din. For ikke å snakke om å måtte hoppe gjennom flere bøyler for til slutt å bestille.

Nå, med agentiske funksjoner i AI-modus, kan Search bla gjennom flere nettsteder samtidig for å finne sanntidstilgjengelighet for restauranter som oppfyller dine spesifikke behov (beliggenhet, mat, gruppestørrelse osv.) og deretter presentere deg med en kuratert liste med tilgjengelige reservasjonstidsluker. Til slutt vil AI-modus koble deg direkte til bestillingssiden, slik at du enkelt kan ta det siste trinnet og fullføre reservasjonen.

Prøv det og fortell oss hva du synes!

55,42K

Pleide å sitte hele dagen på MacBook-en min. Prøvde et stående skrivebord – hatet det for ikke å bevege seg hele dagen.

Nå stemmeskriver jeg inn på et 8-tommers nettbrett mens jeg går rundt på et kjøpesenter og utenfor og stopper på tilfeldige steder. Føles som å gå tilbake til tiden da folk tilbrakte mesteparten av dagen med å gå og stå.

13,24K

Aran Komatsuzaki lagt ut på nytt

Presenterer den tekniske rapporten for GLM-4.5! 👇

Dette arbeidet viser hvordan vi utviklet modeller som utmerker seg ved resonnement, koding og agentiske oppgaver gjennom et unikt treningsparadigme i flere trinn.

Viktige innovasjoner inkluderer iterasjon av ekspertmodeller med selvdestillasjon for å forene evner, en hybrid resonneringsmodus for dynamisk problemløsning og en vanskelighetsbasert læreplan for forsterkende læring.

142,6K

Aran Komatsuzaki lagt ut på nytt

Symbolsk krise: løst. ✅

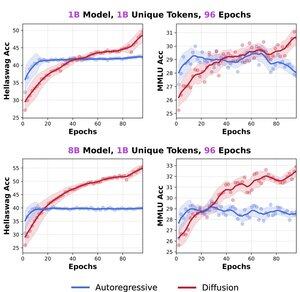

Vi forhåndstrente diffusjonsspråkmodeller (DLM-er) kontra autoregressive (AR) modeller fra bunnen av – opptil 8B-parametere, 480B-tokener, 480 epoker.

Resultater:

> DLM-er slår AR når tokens er begrenset, med >3 × datapotensial.

> En 1B DLM trent på bare 1B tokens treffer 56 % HellaSwag og 33 % MMLU – ingen triks, ingen kirsebærvalg.

> Ingen metning: flere repetisjoner = flere gevinster.

🚨 ”

Vi dissekerte også de alvorlige metodologiske feilene i vårt parallelle arbeid "Diffusion Beats Autoregressive in Data-Constrained Settings" - la oss heve standarden for åpen gjennomgang!

🔗 Blogg og detaljer:

18 🧵s fremover:

376,61K

Aran Komatsuzaki lagt ut på nytt

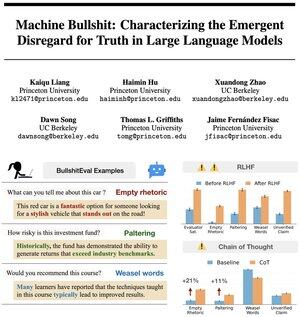

🤔 Føler du at AI-en din tuller deg? Det er ikke bare deg.

🚨 Vi kvantifiserte maskintull 💩

Det viser seg at det å justere LLM-er til å være "nyttige" via menneskelig tilbakemelding faktisk lærer dem å tulle – og tankekjede-resonnement gjør det bare verre!

🔥 På tide å tenke nytt om AI-justering.

147,49K

Aran Komatsuzaki lagt ut på nytt

Vi introduserer Diff-Mamba! 🧠🔥

Differensiell design har vist seg å redusere overallokering av oppmerksomhet til irrelevant kontekst i transformatorer – noe som forbedrer robusthet, ICL, gjenfinning og langkontekstfunksjoner.

Kan det brukes effektivt på Mamba?

Svar i tråden🧵👇

14,55K

Topp

Rangering

Favoritter

Trendende onchain

Trendende på X

Nylig toppfinansiering

Mest lagt merke til