المواضيع الرائجة

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

يجادل جي بي مورغان بأن المعالجات الرسومية تعمل تقريبا بكامل طاقتها، فإن مخاوف الذكاء الاصطناعي مبالغ فيها، وعلى عكس بناء ألياف دوت كوم التي ظلت غير مستغلة بشكل كاف.

لديهم وجهة نظر، لكنني سأرد بالسؤال من يدفع ثمن وحدات معالجة الرسوميات وأين الربح النهائي؟

المشكلة التي نراها مع الذكاء الاصطناعي التوليدي تكمن في الاستخدام الفعلي لهذه المنصات.

الغالبية العظمى مجانية. المستويات المدفوعة لها فائدة أقل بكثير. خصوصا في شركات مثل OpenAI حيث تواجه صعوبة حقيقية في تحويل المستخدمين المجانيين.

حالات الاستخدام في تزايد، لكنها لا تزال تواجه تحديات مقارنة بالقدرات التي تم بناؤها والتخطيط لها.

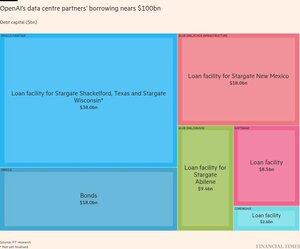

لهذا أعتقد أن هذا الرسم البياني مضلل بعض الشيء، لأنه من النظرة الأولى يشير إلى وجود استخدام هائل وبالتالي لا ينبغي أن نقلق عليه. لكن إذا كان الاستخدام مدفوعا بشكل كبير بالمستخدمين المجانيين الذين يواجهون خسائر، فهو ليس نموذجا مستداما للشركات التي تدعمه، أليس كذلك؟

وبالحديث عن الاستخدام، هل يعتقد أحد حقا أن $META ستصل إلى 8681.4 ميغاواط من الطاقة السعية؟

وهذا سيكون ما يقرب من 4 أضعاف القدرة الإجمالية وحوالي 30 ضعف سعة $META حاليا.

ومع ذلك، لم يظهر $META أي تقدم الذكاء الاصطناعي حقيقي خلال العام. 🤔

ففي النهاية، 95٪ من المؤسسات التي تستثمر في الذكاء الاصطناعي التوليدي لا تحقق عائدا حقيقيا.

وهنا تكمن المشكلة.

الحاجز الأساسي ليس السعة!

إنها قيود في الذكاء الاصطناعي التوليدي نفسه. قيود لا تحل بواسطة الذكاء الاصطناعي الوكيل، أو RAG، أو أي تعزيزات وطبقات أخرى.

وفي الوقت نفسه، هناك سباق لبناء سعة مراكز البيانات من المحتمل ألا نحتاجه.

1) لا نعرف ما إذا كان مستقبل الذكاء الاصطناعي مدعوما بوحدات معالجة الرسوميات التي تستهلك الطاقة

2) أو إذا كانت النماذج العامة الكبيرة وغير الفعالة هي ما سنستخدمه مقابل نماذج صغيرة متخصصة

لماذا نبني؟

ما نعرفه هو أن أكبر 9 شركات في مؤشر S&P 500، والتي تشكل 37.89٪ من وزن القيمة السوقية، قد ارتبطت بدرجات متفاوتة بالذكاء الاصطناعي التوليدي كجزء كبير من قصة نموها المستقبلية. ما إذا كان ذلك سيصبح مستداما هو سؤال حاسم.

100.31K

الأفضل

المُتصدِّرة

التطبيقات المفضلة