Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Tim Dettmers

À mon avis, SWE-bench et T-bench sont les rares benchmarks qui ont un bon signal en termes de progrès que nous réalisons avec les modèles. Ce modèle fonctionne aussi bien que Qwen3 Coder et est seulement 10 % moins performant que GPT-5, tout en étant un LLM polyvalent plutôt que spécialisé dans le code.

Z.ai11 août, 11:43

Présentation du rapport technique GLM-4.5 !👇

Ce travail démontre comment nous avons développé des modèles qui excellent dans le raisonnement, le codage et les tâches agentiques grâce à un paradigme d'entraînement unique en plusieurs étapes.

Les innovations clés incluent l'itération de modèles experts avec auto-distillation pour unifier les capacités, un mode de raisonnement hybride pour la résolution dynamique de problèmes, et un curriculum d'apprentissage par renforcement basé sur la difficulté.

28,52K

Tim Dettmers a reposté

Pluie de pensées : Au lieu de garder votre paiement Twitter/𝕏, dirigez-le vers un "PayoutChallenge" de votre choix - tout ce que vous voulez voir davantage dans le monde !

Voici le mien pour ce tour, combinant mes 3 derniers paiements de 5478,51 $ :

Il est impératif que l'humanité ne tombe pas pendant que l'IA s'élève. L'humanité doit continuer à s'élever, à devenir meilleure en parallèle. Créez quelque chose qui est spécifiquement conçu pour élever l'équipe humaine. La définition est intentionnellement laissée un peu vague pour garder une certaine entropie autour de l'interprétation des gens, mais à mon avis, des exemples incluent :

- Tout logiciel qui aide à l'explication, à la visualisation, à la mémorisation, à l'inspiration, à la compréhension, à la coordination, etc...

- Cela ne doit pas être trop ambitieux, par exemple, cela peut être un article/vidéo éducatif spécifique expliquant quelque chose dont d'autres personnes pourraient bénéficier ou dont vous avez une connaissance unique.

- Prompts/agents pour l'explication, par exemple dans le style du mode d'étude récemment publié de ChatGPT.

- Œuvres d'art connexes

Ce défi se déroulera pendant 2 semaines jusqu'au 17 août à la fin de la journée PST. Soumettez votre contribution en réponse. Cela doit être quelque chose qui a été créé spécifiquement pour ce défi et qui n'existerait pas autrement. Les critères incluent l'exécution, l'impact, la nouveauté, l'inspiration, l'esthétique, l'amusement. Les gens peuvent voter pour les soumissions en aimant, ce "choix du peuple" sera également un facteur. Je déciderai du gagnant le 17 août et enverrai 5478,51 $ :)

676,38K

Tim Dettmers a reposté

Quelques mises à jour 🚨

J’ai terminé mon doctorat à @uwcse en juin 2025 !

Après une année à AI2 en tant que chercheur scientifique, je rejoindrai CMU @LTIatCMU & @mldcmu (autorisation) en tant que professeur adjoint à l’automne 2026.

Le parcours, les remerciements et le recrutement en 🧵

98,79K

Tim Dettmers a reposté

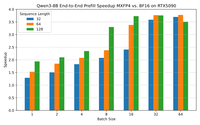

Nous annonçons nos premiers travaux sur l’inférence FP4 pour les LLM !

- QuTLASS : prise en charge du noyau de faible précision pour les GPU Blackwell

- FP-Quet : un harnais de quantification flexible pour Lama/Qwen

Nous atteignons une accélération de 4x par rapport à BF16, avec une bonne précision grâce à la micro-mise à l’échelle MXFP4 + rotations Hadamard fusionnées.

22,55K

Tim Dettmers a reposté

La tokenisation n’est qu’un cas particulier de « chunking » - la construction de données de bas niveau en abstractions de haut niveau - qui est à son tour fondamentale pour l’intelligence.

Notre nouvelle architecture, qui permet le *chunking dynamique* hiérarchique, est non seulement sans tokenizer, mais évolue tout simplement mieux.

194,73K

Tim Dettmers a reposté

Le plus grand ensemble de données de code GPU écrit par des humains, entièrement open-source ? 👀 OUI, s'il vous plaît ! Nous, chez @GPU_MODE, avons publié environ 40k 🚀 échantillons de code écrits par des humains couvrant Triton, Hip et PyTorch, et tout est disponible sur le Hub @huggingface. Entraînez le nouveau GPT pour rendre les GPT plus rapides ⚡️

Lien ci-dessous ⬇️

28,87K

Tim Dettmers a reposté

J'aime vraiment ce résultat : un encadrement élégant et une solution pour améliorer significativement la généralisation de la longueur dans les modèles récurrents en général (RNN/SSM/attention linéaire/etc).

Cela a des implications significatives pour les problèmes sur lesquels les chercheurs en architecture devraient se concentrer, à mon avis.

13,06K

Tim Dettmers a reposté

Je devrais probablement annoncer qu’il y a quelques mois, j’ai rejoint @scale_AI pour diriger le laboratoire de sécurité, d’évaluation et d’alignement... et aujourd’hui, j’ai rejoint @Meta pour continuer à travailler sur l’alignement de l’IA avec @summeryue0 et @alexandr_wang. Très enthousiaste à l’idée de ce que nous pouvons accomplir ensemble !

40,81K

Tim Dettmers a reposté

À quoi ressemblera le développement de logiciels en 2026 ?

Avec l’amélioration rapide des agents de codage, les rôles de développement peuvent être très différents. Mon flux de travail actuel a beaucoup changé :

- Travailler dans github, pas dans les IDE

- Agents en parallèle

- Écrivez en anglais, pas en code

- Plus de révision de code

Réflexions + une vidéo👇

15,62K

Tim Dettmers a reposté

📢Maintenant ouvert, Gemma 3n pèse et il est nativement flexible, le premier du genre, grâce à MatFormer🪆

N’importe quel modèle entre E4B et E2B avec ZÉRO formation près de Pareto - nous en avons trouvé un tas !

Trouvez un meilleur E3B que ce que nous avons sorti, je vous enverrai un 🪆😉

Trouver le colab pour l’extraction 🧵👇🪆

30,71K

Meilleurs

Classement

Favoris

Tendance on-chain

Tendance sur X

Récents financements de premier plan

Les plus notables