Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Tim Dettmers

Na minha opinião, o SWE-bench e o T-bench são os poucos benchmarks que têm um bom sinal em termos de quanto progresso fazemos com os modelos. Este modelo tem um desempenho tão bom quanto o Qwen3 Coder e é apenas 10% pior que o GPT-5, sendo também um LLM de propósito geral em vez de especializado em código.

Z.ai11/08, 11:43

Apresentando o relatório técnico GLM-4.5!👇

Este trabalho demonstra como desenvolvemos modelos que se destacam em raciocínio, codificação e tarefas agentivas através de um paradigma de treinamento único e em múltiplas etapas.

As principais inovações incluem iteração de modelos especialistas com auto-destilação para unificar capacidades, um modo de raciocínio híbrido para resolução dinâmica de problemas e um currículo de aprendizado por reforço baseado em dificuldade.

28,51K

Tim Dettmers republicou

Chuva de pensamentos: Em vez de manter o seu pagamento do Twitter/𝕏, direcione-o para um "Desafio de Pagamento" à sua escolha - qualquer coisa que você queira ver mais no mundo!

Aqui está o meu para esta rodada, combinando os meus últimos 3 pagamentos de $5478.51:

É imperativo que a humanidade não caia enquanto a IA ascende. A humanidade tem que continuar a subir, tornar-se melhor ao lado da IA. Crie algo que seja especificamente projetado para elevar a equipe humana. A definição foi intencionalmente deixada um pouco vaga para manter alguma entropia em torno da interpretação das pessoas, mas na minha opinião, exemplos incluem:

- Qualquer peça de software que ajude na explicação, visualização, memorização, inspiração, compreensão, coordenação, etc...

- Não precisa ser muito grandioso, por exemplo, pode ser um artigo/vídeo educacional específico que explique algo que outras pessoas poderiam beneficiar ou que você tenha conhecimento único.

- Prompts/agentes para explicação, por exemplo, na linha do modo de estudo do ChatGPT recentemente lançado.

- Obras de arte relacionadas

Este desafio irá decorrer por 2 semanas até 17 de agosto, EOD PST. Envie sua contribuição como uma resposta. Tem que ser algo que foi criado exclusivamente para este desafio e que não existiria de outra forma. Os critérios incluem execução, aproveitamento, novidade, inspiração, estética, diversão. As pessoas podem votar nas submissões gostando, esta "escolha do povo" também será um fator. Eu decidirei o vencedor em 17 de agosto e enviarei $5478.51 :)

676,38K

Tim Dettmers republicou

Algumas atualizações 🚨

Terminei o meu doutoramento em @uwcse em junho de 2025!

Depois de um ano no AI2 como Cientista de Pesquisa, estou me juntando à CMU @LTIatCMU e @mldcmu (cortesia) como Professor Assistente no outono de 2026.

A jornada, os agradecimentos e o recrutamento em 🧵

98,79K

Tim Dettmers republicou

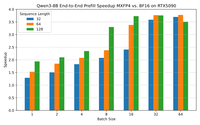

Anunciando nosso trabalho inicial na inferência do FP4 para LLMs!

- QuTLASS: suporte de kernel de baixa precisão para GPUs Blackwell

- FP-Quant: um arnês de quantização flexível para Llama/Qwen

Atingimos uma velocidade de 4x vs BF16, com boa precisão através de microescalonamento MXFP4 + rotações Hadamard fundidas.

22,55K

Tim Dettmers republicou

A tokenização é apenas um caso especial de "fragmentação" - construção de dados de baixo nível em abstrações de alto nível - que, por sua vez, é fundamental para a inteligência.

Nossa nova arquitetura, que permite o *dynamic chunking hierárquico*, não é apenas livre de tokenizadores, mas simplesmente dimensiona melhor.

194,73K

Tim Dettmers republicou

O maior conjunto de dados de código de GPU escrito humano todo de código aberto? 👀 Sim, por favor! Nós da @GPU_MODE lançamos cerca de 40 mil 🚀 amostras de código escrito humano abrangendo Triton, Hip e PyTorch e está tudo aberto no @huggingface Hub. Treine o novo GPT para tornar os GPTs mais rápidos ⚡️

Link abaixo ⬇️

28,87K

Tim Dettmers republicou

Gosto muito deste resultado: uma moldura e solução elegantes para melhorar significativamente a generalização de comprimento em modelos recorrentes em grande escala (RNNs/SSMs/atenção linear/etc).

Isto tem implicações significativas para os problemas em que os investigadores de arquitetura devem se concentrar, na minha opinião.

13,06K

Tim Dettmers republicou

Devo provavelmente anunciar que, há alguns meses, entrei na @scale_AI para liderar o Laboratório de Segurança, Avaliações e Alinhamento... e hoje, juntei-me à @Meta para continuar a trabalhar no alinhamento da IA com @summeryue0 e @alexandr_wang. Muito animado para o que podemos realizar juntos!

40,81K

Tim Dettmers republicou

Como será o desenvolvimento de software em 2026?

Com os agentes de codificação melhorando rapidamente, as funções de desenvolvimento podem parecer bastante diferentes. Meu fluxo de trabalho atual mudou muito:

- Trabalhar no github, não em IDEs

- Agentes em paralelo

- Escreva inglês, não código

- Mais revisão de código

Pensamentos + um vídeo👇

15,62K

Tim Dettmers republicou

📢Agora aberto, o Gemma 3n pesa e é nativamente flexível, o primeiro de seu tipo, graças ao MatFormer🪆

Qualquer modelo entre E4B e E2B com treinamento ZERO perto de Pareto -- encontramos um grupo!

Encontre um E3B melhor do que o que lançamos, vou enviar-lhe um 🪆😉

Encontre o colab para extração 🧵👇🪆

30,71K

Top

Classificação

Favoritos

Tendências on-chain

Popular no X

Principais financiamentos atuais

Mais notável