Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Tim Dettmers

A mio avviso, SWE-bench e T-bench sono i pochi benchmark che hanno un buon segnale in termini di quanto progresso facciamo con i modelli. Questo modello si comporta altrettanto bene quanto Qwen3 Coder ed è solo il 10% peggiore di GPT-5, pur essendo un LLM di uso generale piuttosto che specializzato nel codice.

Z.ai11 ago, 11:43

Presentazione del rapporto tecnico GLM-4.5!👇

Questo lavoro dimostra come abbiamo sviluppato modelli che eccellono nel ragionamento, nella codifica e nei compiti agentici attraverso un paradigma di formazione unico e multi-fase.

Le principali innovazioni includono l'iterazione del modello esperto con auto-distillazione per unificare le capacità, una modalità di ragionamento ibrida per la risoluzione dinamica dei problemi e un curriculum di apprendimento rinforzato basato sulla difficoltà.

28,52K

Tim Dettmers ha ripubblicato

Doccia di pensieri: Invece di tenere il tuo pagamento di Twitter/𝕏, indirizzalo verso una "PayoutChallenge" a tua scelta - qualsiasi cosa tu voglia di più nel mondo!

Ecco la mia per questo turno, combinando i miei ultimi 3 pagamenti di $5478.51:

È imperativo che l'umanità non cada mentre l'IA ascende. L'umanità deve continuare a elevarsi, a diventare migliore insieme. Crea qualcosa che sia specificamente progettato per sollevare il team umano. La definizione è intenzionalmente lasciata un po' vaga per mantenere un po' di entropia nell'interpretazione delle persone, ma secondo me gli esempi includono:

- Qualsiasi pezzo di software che aiuti spiegazione, visualizzazione, memorizzazione, ispirazione, comprensione, coordinazione, ecc...

- Non deve essere troppo ambizioso, ad esempio può essere un articolo/video educativo specifico che spiega qualcosa da cui altre persone potrebbero trarre beneficio o di cui hai conoscenze uniche.

- Prompts/agenti per spiegazione, ad esempio lungo le linee della modalità studio di ChatGPT recentemente rilasciata.

- Opere d'arte correlate

Questa sfida durerà per 2 settimane fino al 17 agosto EOD PST. Invia il tuo contributo come risposta. Deve essere qualcosa che è stato creato unicamente per questa sfida e che non esisterebbe altrimenti. I criteri includono esecuzione, leverage, novità, ispirazione, estetica, divertimento. Le persone possono votare le proposte mettendo mi piace, questa "scelta del popolo" sarà anche un fattore. Deciderò il vincitore il 17 agosto e invierò $5478.51 :)

676,38K

Tim Dettmers ha ripubblicato

Alcuni aggiornamenti 🚨

Ho terminato il mio dottorato di ricerca a @uwcse nel giugno 2025!

Dopo un anno in AI2 come ricercatore, entrerò a far parte di CMU @LTIatCMU & @mldcmu (per gentile concessione) come Assistant Professor nell'autunno del 2026.

Il viaggio, i riconoscimenti e il reclutamento in 🧵

98,79K

Tim Dettmers ha ripubblicato

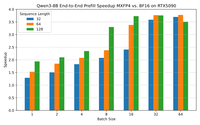

Annunciamo il nostro primo lavoro sull'inferenza FP4 per gli LLM!

- QuTLASS: supporto del kernel a bassa precisione per le GPU Blackwell

- FP-Quant: un cablaggio di quantizzazione flessibile per Llama/Qwen

Raggiungiamo un'accelerazione 4x rispetto a BF16, con una buona precisione grazie al microscaling MXFP4 + rotazioni Hadamard fuse.

22,55K

Tim Dettmers ha ripubblicato

La tokenizzazione è solo un caso speciale di "chunking" - la costruzione di dati di basso livello in astrazioni di alto livello - che è a sua volta fondamentale per l'intelligenza.

La nostra nuova architettura, che consente la suddivisione gerarchica in blocchi dinamici, non solo è priva di tokenizzatore, ma semplicemente si adatta meglio.

194,73K

Tim Dettmers ha ripubblicato

Il più grande set di dati di codice GPU scritto dall'uomo, tutto open-source? 👀 SÌ, per favore! Noi di @GPU_MODE abbiamo rilasciato circa 40k 🚀 campioni di codice scritto umano che vanno da Triton, Hip e PyTorch ed è tutto aperto sul @huggingface Hub. Addestra il nuovo GPT per renderlo più veloce ⚡️

Link sottostante ⬇️

28,87K

Tim Dettmers ha ripubblicato

Mi piace davvero questo risultato: una cornice elegante e una soluzione per migliorare significativamente la generalizzazione della lunghezza nei modelli ricorrenti in generale (RNN/SSM/attenzione lineare/ecc).

Questo ha implicazioni significative per i problemi su cui i ricercatori di architettura dovrebbero concentrarsi, secondo me.

13,06K

Tim Dettmers ha ripubblicato

Probabilmente dovrei annunciare che qualche mese fa sono entrato a far parte di @scale_AI per guidare il Laboratorio di Sicurezza, Valutazioni e Allineamento... e oggi sono entrato a far parte di @Meta per continuare a lavorare sull'allineamento dell'IA con @summeryue0 e @alexandr_wang. Molto entusiasta di ciò che possiamo realizzare insieme!

40,81K

Tim Dettmers ha ripubblicato

Come sarà lo sviluppo del software nel 2026?

Con il rapido miglioramento degli agenti di codifica, i ruoli di sviluppo possono apparire molto diversi. Il mio attuale flusso di lavoro è cambiato molto:

- Lavora in github, non negli IDE

- Agenti in parallelo

- Scrivi in inglese, non codice

- Più revisione del codice

Pensieri + un video👇

15,62K

Tim Dettmers ha ripubblicato

📢Ora aperto, Gemma 3n pesa ed è nativamente flessibile, primo nel suo genere, grazie a MatFormer🪆

Qualsiasi modello tra E4B ed E2B con formazione ZERO vicino a Pareto - ne abbiamo trovati un sacco!

Trova un E3B migliore di quello che abbiamo rilasciato, ti manderò un 🪆😉

Trova la colab per l'estrazione 🧵👇🪆

30,71K

Principali

Ranking

Preferiti

On-chain di tendenza

Di tendenza su X

Principali fondi recenti

Più popolari