Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Adam Wolff

Claude Code @AnthropicAI 🤖

Bucătar pasionat, om dedicat zăpezii, pasionat de yoga

Încă accelerăm. Sub-agenții sunt acum o caracteristică de primă clasă în Claude Code. Abia aștept să văd ce construiești cu ei.

O treabă grozavă la acest @sidbidasaria

SidCu 23 de ore în urmă

Claude Code primește o caracteristică nouă: subagenți personalizați.

Tastați "/agents" pentru a începe.

32,55K

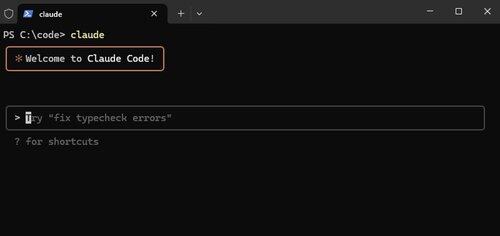

Claude Code, acum nativ pe Windows.

Funcții ca aceasta nu sunt strălucitoare, dar îl fac pe Claude Code *atât de puternic). Vrem să ruleze oriunde te duci.

Alex Albert15 iul., 03:07

Avem o altă actualizare importantă pentru Claude Code astăzi: este acum disponibilă nativ pentru Windows.

13,06K

"În timp ce competiția pare o forță puternică, colaborarea este singura forță mai puternică."

@tomocchino ❤️

Ryan Vogel13 iul., 01:50

Vezi prima parte a celui mai nou episod al nostru cu @tomocchino de la @vercel

(mulțumesc din nou lui Vercel pentru că ne-a lăsat să filmăm la sediu)

10,22K

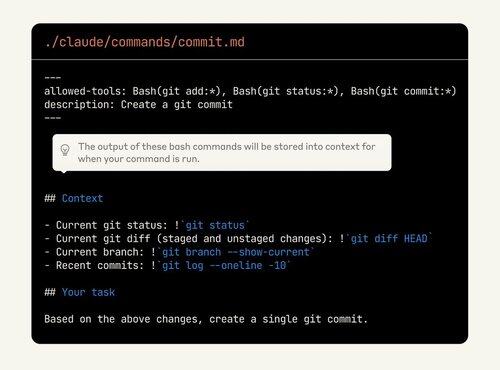

Claude Code este atât de personalizabil, dar caracteristicile sunt greu de descoperit. Mulți oameni dorm pe puterea comenzilor personalizate. Acum pot chiar să încorporeze ieșirea bash!

Aruncați o altă privire dacă nu utilizați deja aceste funcții.

Alex Albert2 iul., 00:19

Ca o reamintire, comenzile cu bară oblică vă permit să stocați solicitări personalizate ca fișiere Markdown și să le invocați cu /your-command.

Cu această actualizare, acum puteți:

- Executați comenzi bash din comenzi slash

- @ menționează fișiere pentru context

- Activați gândirea extinsă cu cuvinte cheie în comenzi

10,02K

Evaluările de astăzi sunt ca testele de acum un deceniu. Evident important, dar și neclar exact cum și cât să investească.

Acesta este un sfat grozav, dar cel mai important lucru este să încerci. Dacă produsul tău încorporează AI și nu ai evaluări, construiești un castel din nisip.

shyamal20 mai 2025

Începerea cu evaluările nu necesită prea multe. modelul pe care l-am văzut funcționând pentru echipele mici seamănă foarte mult cu dezvoltarea bazată pe teste aplicată ingineriei AI:

1/ Ancorați evaluările în poveștile utilizatorilor, nu în benchmark-uri abstracte: stați de vorbă cu omologul dvs. produs/design și enumerați lucrurile concrete pe care modelul dvs. trebuie să le facă pentru utilizatori. "răspundeți cu precizie la întrebările privind cererile de despăgubire", "generați interogări SQL din limbaj natural". Pentru fiecare, scrieți 10-20 de intrări reprezentative și ieșirile/comportamentele dorite. Acesta este primul fișier de evaluare.

2/ Automatizați din prima zi, chiar dacă este fragil. rezistă tentației de a "doar privi". Ei bine, OK, vibrațiile nu se scalează prea mult timp. Înfășurați-vă evaluările în cod. Puteți scrie un pytest simplu care trece în buclă peste exemplele dvs., apelează modelul și afirmă că apar anumite subșiruri. Este crud, dar este un început.

3/ Utilizați modelul pentru a porni date de evaluare mai dificile. Scrierea manuală a sute de cazuri limită este costisitoare. Puteți utiliza modele de raționament (O3) pentru a genera variații sintetice ("Dați-mi 50 de întrebări de revendicare care implică daune provocate de incendiu") și apoi filtrați manual. Acest lucru accelerează acoperirea fără a sacrifica relevanța.

4/ Nu urmăriți clasamentele; iterați pe ceea ce eșuează. Când ceva eșuează în producție, nu remediați doar solicitarea - adăugați cazul eșuat la setul de evaluare. În timp, suita ta va crește pentru a reflecta modurile tale reale de eșec. Împărțiți periodic evaluările (după lungimea de intrare, după setările regionale etc.) pentru a vedea dacă regresați pe anumite segmente.

5/ Dezvoltați-vă valorile pe măsură ce produsul se maturizează. Pe măsură ce scalați, veți dori un scor mai nuanțat (similitudine semantică, evaluări umane, urmărirea costului/latenței). Construiți cârlige în hamul de evaluare pentru a le înregistra și a le tendința în timp. instrumentați-vă interfața de utilizare pentru a colecta feedback implicit (utilizatorul a făcut clic pe "degetul mare în sus"?) și alimentați-l înapoi în evaluările offline.

6/ Faceți vizibile evaluările. Puneți un tablou de bord simplu în fața echipei și a părților interesate care să arate ratele de promovare, costul, latența. Folosește-l în stand-up-uri. acest lucru creează responsabilitate și îi ajută pe cei care nu sunt ML să participe la discuțiile de compromis.

În cele din urmă, tratați evaluările ca pe un artefact ingineresc de bază. Atribuiți proprietatea, revizuiți-le în revizuirea codului, sărbătoriți când adăugați un nou caz dificil. disciplina va plăti dividende compuse pe măsură ce vă extindeți.

1,17K

Limită superioară

Clasament

Favorite

La modă pe lanț

La modă pe X

Principalele finanțări recente

Cele mai importante