Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Adam Wolff

Codice Claude @AnthropicAI 🤖

Cuoco appassionato, uomo della neve dedicato, appassionato di yoga

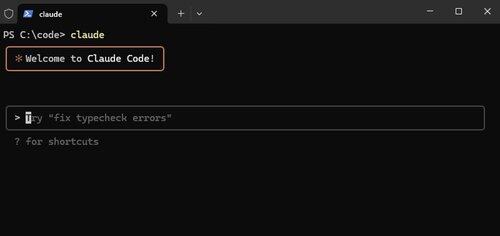

Claude Code, ora nativo su Windows.

Funzionalità come questa non sono appariscenti, ma rendono Claude Code *così* potente. Vogliamo che funzioni ovunque tu lo faccia.

Alex Albert15 lug, 03:07

Abbiamo un altro grande aggiornamento per Claude Code oggi: è ora disponibile nativamente per Windows.

13,03K

"Mentre la competizione sembra una forza potente, la collaborazione è l'unica forza più potente."

@tomocchino ❤️

Ryan Vogel13 lug, 01:50

dai un'occhiata alla prima parte del nostro episodio più recente con @tomocchino di @vercel

(grazie ancora a vercel per averci permesso di girare presso la sede)

10,2K

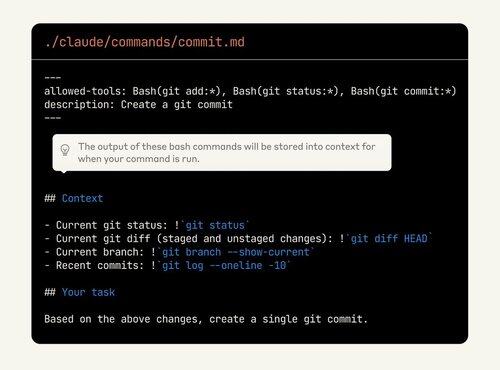

Claude Code è così personalizzabile, ma le funzionalità sono difficili da scoprire. Molte persone stanno sottovalutando il potere dei comandi personalizzati. Ora possono persino incorporare l'output di bash!

Dai un'altra occhiata se non stai già utilizzando queste funzionalità.

Alex Albert2 lug, 00:19

Come promemoria, i comandi slash ti permettono di memorizzare prompt personalizzati come file Markdown e richiamarli con /tuo-comando.

Con questo aggiornamento, ora puoi:

- Eseguire comandi bash dai comandi slash

- Menzionare file per contesto

- Abilitare un pensiero esteso con parole chiave all'interno dei comandi

10K

Le valutazioni di oggi sono come i test di un decennio fa. Ovviamente importante, ma anche poco chiaro esattamente come e quanto investire.

Questo è un ottimo consiglio, ma la cosa più importante è provare. Se il tuo prodotto incorpora l'intelligenza artificiale e non hai valutazioni, stai costruendo un castello fatto di sabbia.

shyamal20 mag 2025

Iniziare con le valutazioni non richiede troppo. il modello che abbiamo visto funzionare per piccoli team assomiglia molto allo sviluppo basato su test applicato all'ingegneria dell'intelligenza artificiale:

1/ Valutazioni di ancoraggio nelle storie degli utenti, non in benchmark astratti: siediti con la tua controparte di prodotto/design ed elenca le cose concrete che il tuo modello deve fare per gli utenti. "rispondere in modo accurato alle domande sui sinistri assicurativi", "generare query SQL dal linguaggio naturale". Per ciascuno, scrivi 10-20 input rappresentativi e gli output/comportamenti desiderati. Questo è il tuo primo file di valutazione.

2/ Automatizza fin dal primo giorno, anche se è fragile. Resisti alla tentazione di "guardarlo a occhio". Beh, ok, Vibes non scala troppo a lungo. Racchiudi le tue valutazioni nel codice. È possibile scrivere un semplice pytest che esegue il ciclo sugli esempi, chiama il modello e asserisce la visualizzazione di determinate sottostringhe. È rozzo, ma è un inizio.

3/ Utilizzare il modello per avviare dati di valutazione più difficili. Scrivere manualmente centinaia di casi limite è costoso. È possibile utilizzare i modelli di ragionamento (O3) per generare variazioni sintetiche ("Dammi 50 domande di reclamo che coinvolgono danni da incendio") e quindi filtrare a mano. Ciò accelera la copertura senza sacrificare la rilevanza.

4/ non inseguire le classifiche; iterare su ciò che non riesce. Quando qualcosa non funziona in produzione, non limitarti a correggere il prompt: aggiungi il caso di errore al tuo set di valutazione. Nel corso del tempo la tua suite crescerà fino a riflettere le tue reali modalità di fallimento. Analizza periodicamente le tue valutazioni (in base alla lunghezza dell'input, alla localizzazione, ecc.) per vedere se stai regredendo su determinati segmenti.

5/ Fai evolvere le tue metriche man mano che il tuo prodotto matura. Man mano che si scala, è necessario ottenere punteggi più sfumati (somiglianza semantica, valutazioni umane, monitoraggio costi/latenza). Costruisci ganci nella tua imbracatura EVAL per registrarli e farli andare nel tempo. strumentalizza la tua interfaccia utente per raccogliere feedback impliciti (l'utente ha fatto clic su "pollice in su"?) e reinserirli nelle tue valutazioni offline.

6/ Rendere visibili le valutazioni. Metti una semplice dashboard di fronte al team e alle parti interessate che mostra i tassi di superamento della valutazione, i costi e la latenza. Usalo negli stand-up. questo crea responsabilità e aiuta le persone non ML a partecipare alle discussioni sul compromesso.

Infine, considera le valutazioni come un artefatto ingegneristico di base. Assegna la proprietà, esaminali nella revisione del codice, festeggia quando aggiungi un nuovo caso complicato. La disciplina pagherà dividendi composti man mano che cresci.

1,15K

Principali

Ranking

Preferiti

On-chain di tendenza

Di tendenza su X

Principali fondi recenti

Più popolari