熱門話題

#

Bonk 生態迷因幣展現強韌勢頭

#

有消息稱 Pump.fun 計劃 40 億估值發幣,引發市場猜測

#

Solana 新代幣發射平臺 Boop.Fun 風頭正勁

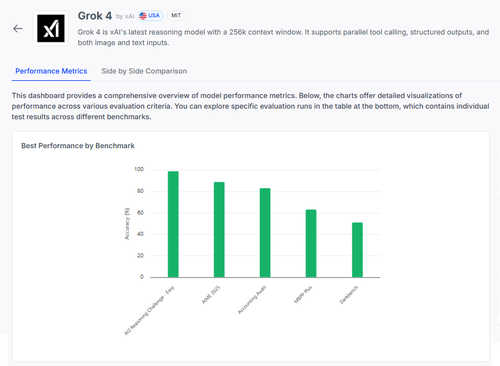

🧠 Grok 4 由 @xai 開發,在推理基準測試中取得了進展,但情況比分數所暗示的更為複雜。

以下是它的表現 — 以及我們可以從其結果中真正學到的東西 🧵

📊 完整評估:

1️⃣ Grok 4 分數:

• AI2 推理挑戰(簡單):98%

• AIME 2025(數學):89%

• 會計審計:84%

• MMLU-Plus:64%

• Data4Health:55%

這些是總體分數 — 但讓我們深入了解哪些方面運作良好,哪些仍然失敗。

2️⃣ AIME 2025

✅ 處理代數、幾何、數論

✅ 遵循 LaTeX 格式規則

❌ 在多步邏輯上掙扎

❌ 組合數學出錯

❌ 格式精確性問題(例如,缺少 °)

3️⃣ 會計審計

✅ 在倫理和報告方面表現強勁

✅ 對審計原則有扎實的理解

❌ 錯誤解釋相似程序

❌ 無法察覺微妙的答案差異

❌ 將理論應用於現實案例時困難重重

4️⃣ 真正的見解?

即使在某些任務上得分達到 98% 的模型,在模糊或格式壓力下也可能會嚴重失敗。

像 AIME 和審計這樣的基準顯示了它的失敗,而不僅僅是它的得分。

5️⃣ 為什麼這很重要:

我們需要透明的逐任務評估 — 而不僅僅是排行榜。

#Grok4 功能強大,但在高風險的現實世界領域中仍然脆弱。

🧪 探索完整的分析:

#AI #LLMs #基準測試

1.04K

熱門

排行

收藏