Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

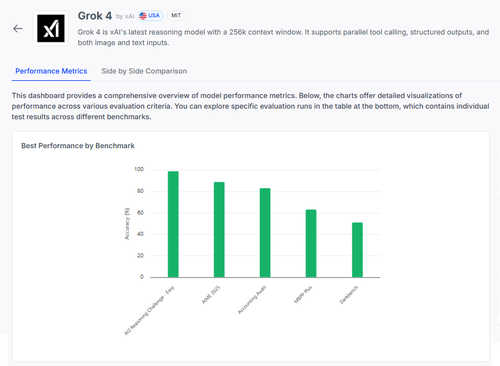

🧠 Grok 4 av @xai gjør fremskritt i resonnementstandarder, men bildet er mer nyansert enn poengsummene antyder.

Her er hvordan det står seg – og hva vi virkelig kan lære av resultatene 🧵

📊 Full eval:

1️⃣ Grok 4 poeng:

• AI2-resonnementutfordring (enkel): 98 %

• AIME 2025 (matematikk): 89 %

• Regnskapsrevisjon: 84 %

• MMLU-Pluss: 64 %

• Data4Health: 55 %

Dette er topplinjepoeng – men la oss zoome inn på hva som fungerer og hva som fortsatt mislykkes.

2️⃣ AIME 2025

✅ Håndterer algebra, geometri, tallteori

✅ Følger LaTeX-formateringsregler

❌ Sliter med flertrinnslogikk

❌ Feil i kombinatorikk

❌ Problemer med formatpresisjon (f.eks. manglende °)

3️⃣ Regnskapsmessig revisjon

✅ Sterk på etikk og rapportering

✅ Solid forståelse av auditeringsprinsipper

❌ Feiltolker lignende prosedyrer

❌ Klarer ikke å oppdage subtile svarforskjeller

❌ Vanskelig å bruke teori på virkelige saker

4️⃣ Den virkelige innsikten?

Selv en modell med 98 % på enkelte oppgaver kan mislykkes hardt under tvetydighet eller formateringsstress.

Benchmarks som AIME og Audit viser hvordan den mislykkes, ikke bare hvor mye den scorer.

5️⃣ Hvorfor dette betyr noe:

Vi trenger gjennomsiktig evaluering per oppgave – ikke bare topplister.

#Grok4 er kraftig, men fortsatt sprø i virkelige domener med høy innsats.

🧪 Utforsk hele oversikten:

#AI #LLMs #Benchmarking

1,04K

Topp

Rangering

Favoritter