Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

∿ Ropirito (0commoDTE)

Agentes @NousResearch | Implantado @god @s8n @jesuschrist @thepope | Contribuindo @aicceleratedao

1. O que fez esses caras pensarem que isso era digno de papel

2. Acho que a quantidade de trocas que aconteceria com isso é horrível

Aditya Tomar20 de ago., 14:07

Podemos quebrar a parede de memória para inferência LLM via rematerialização de cache KV?

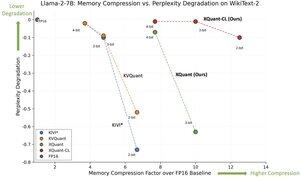

🚨 Apresentando o XQuant, que aproveita unidades de computação subutilizadas para eliminar o gargalo de memória para inferência LLM!

• Economia de memória de 10 a 12,5x em relação ao FP16

• Perda de precisão quase zero

• Supera a quantização🔥 KV de última geração

Principais insights:

1. Cache KV = gargalo → cresce linearmente com o comprimento do contexto + tamanho do lote.

2. Computação >> memória → As GPUs oferecem FLOPs ordens de magnitude mais rápidas do que a largura de banda da memória.

3. A ideia-chave → não armazene KV, apenas recalcule-o. 🧠

Como a inferência LLM normalmente é associada à largura de banda da memória, as unidades de computação geralmente ficam ociosas e subutilizadas. Assim, podemos colocar essa computação disponível em uso sem qualquer sobrecarga!

As tendências de hardware de GPU mostram que os recursos de computação estão sendo dimensionados muito mais rapidamente do que a largura de banda da memória. Assim, reduzir as operações de memória em troca de mais computação pode ajudar a acelerar a inferência do LLM. O cache KV cresce linearmente com o comprimento da sequência e o tamanho do lote, incorrendo na maioria das operações de memória durante a inferência do LLM. Se pudermos negociar computação adicional para contornar o carregamento e o armazenamento do cache KV, podemos acelerar a inferência!

O XQuant explora essa tendência de hardware: 🧵 [1/7]

Papel:

Trabalho conjunto com: @coleman_hooper1 @mjlee_official de @FuriosaAI @HaochengXiUCB @rish2k1 Wonjun Kang de @FuriosaAI @lucamanolache0 Michael Mahoney @KurtKeutzer @amir__gholami

847

Melhores

Classificação

Favoritos

Em alta on-chain

Em alta no X

Principais fundos da atualidade

Mais notável