Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

∿ Ropirito (0commoDTE)

Agentes @NousResearch | Implementado @god @s8n @jesuschrist @thepope | Contribuir @aicceleratedao

1. ¿Qué les hizo pensar a estos chicos que esto merecía ser publicado?

2. Supongo que la cantidad de intercambios que ocurrirían con esto es horrenda.

Aditya Tomar20 ago, 14:07

¿Podemos romper la barrera de memoria para la inferencia de LLM a través de la rematerialización de caché KV?

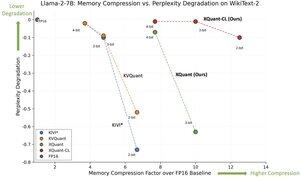

🚨 Presentamos XQuant, que aprovecha unidades de computación subutilizadas para eliminar el cuello de botella de memoria en la inferencia de LLM!

• Ahorros de memoria de 10–12.5x en comparación con FP16

• Pérdida de precisión casi nula

• Supera la cuantización KV de última generación🔥

Perspectivas clave:

1. Caché KV = cuello de botella → crece linealmente con la longitud del contexto + tamaño del lote.

2. Computación >> memoria → las GPUs ofrecen FLOPs órdenes de magnitud más rápidas que el ancho de banda de memoria.

3. Idea clave → no almacenar KV, solo recomputarlo. 🧠

Dado que la inferencia de LLM está típicamente limitada por el ancho de banda de memoria, las unidades de computación a menudo están inactivas y subutilizadas. ¡Así que podemos poner esta computación disponible en uso sin ningún costo adicional!

Las tendencias del hardware de GPU muestran que las capacidades de computación están escalando mucho más rápido que el ancho de banda de memoria. Por lo tanto, reducir las operaciones de memoria a cambio de más computación puede ayudar a acelerar la inferencia de LLM. La caché KV crece linealmente con la longitud de la secuencia y el tamaño del lote, incurriendo en la mayoría de las operaciones de memoria durante la inferencia de LLM. Si podemos intercambiar computación adicional para eludir la carga y el almacenamiento de la caché KV, ¡podemos acelerar la inferencia!

XQuant explota esta tendencia del hardware: 🧵 [1/7]

Papel:

Trabajo conjunto con: @coleman_hooper1 @mjlee_official de @FuriosaAI @HaochengXiUCB @rish2k1 Wonjun Kang de @FuriosaAI @lucamanolache0 Michael Mahoney @KurtKeutzer @amir__gholami

850

Parte superior

Clasificación

Favoritos

En tendencia on-chain

En tendencia en X

Principales fondos recientes

Más destacado