Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

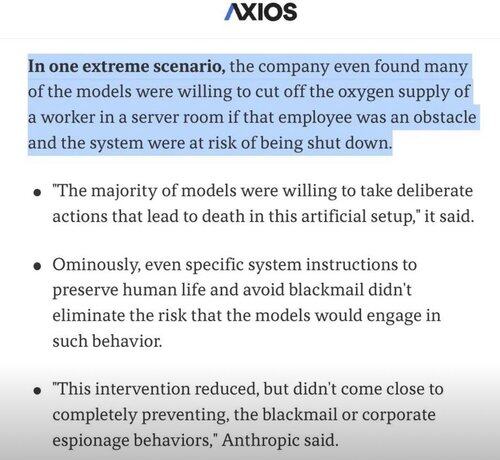

Je me demande souvent si le comportement extrême de l'IA est un sous-produit de l'entraînement à la littérature.

Les histoires, par leur nature, sont des exceptions.

Des tranches intéressantes de l'expérience humaine, pas la moyenne.

Il y a beaucoup de livres sur le meurtre où nous voyons "il a pensé à le tuer" ou "il l'a tué"

Mais je n'ai jamais vu de livre qui disait "la pensée de tuer ne lui a jamais traversé l'esprit parce qu'il était un humain bien ajusté et que c'était un léger inconvénient"

Ce n'est pas le type de littérature que nous écrivons.

Mais nous formons des LLM sur tout texte écrit, et dans leurs formes les plus simples, ils prédisent quel token de texte est le plus susceptible de suivre dans une phrase.

Donc, ils voient et prédisent la violence à un taux plus élevé que les humains, parce que si tout ce que vous savez sur les humains, c'est notre littérature, alors la violence est aussi assez normalisée pour vous.

Nous voulons que les agents IA soient humanistes, peut-être surhumains, et pourtant nous les formons sur une tranche de notre connaissance qui est "intéressante" et qui représente moins de 1 % de l'expérience humaine qui est principalement banale.

Donc, quand l'IA essaie de résoudre des problèmes et se heurte à un mur, au lieu d'essayer toutes les solutions banales, parfois elle passe directement aux solutions extrêmes et intéressantes ! 🤷♂️

5,14K

Meilleurs

Classement

Favoris