Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Często się zastanawiam, czy ekstremalne zachowanie w AI jest skutkiem szkolenia na literaturze.

Opowieści są z natury wyjątkami.

Interesujące fragmenty ludzkiego doświadczenia, a nie przeciętność.

Jest wiele książek o morderstwie, w których widzimy „myślał o zabiciu go” lub „zabił go”.

Ale nigdy nie widziałem książki, która mówiłaby „myśl o zabiciu nigdy nie przyszła mu do głowy, ponieważ był dobrze przystosowanym człowiekiem, a to była drobna niedogodność”.

To nie jest ten rodzaj literatury, który piszemy.

Ale szkolimy LLM na wszystkich tekstach pisanych, a w ich najprostszej formie przewidują, jaki token tekstu jest najbardziej prawdopodobny następny w zdaniu.

Więc widzą i przewidują przemoc w wyższym stopniu niż ludzie, ponieważ jeśli wszystko, co wiesz o ludziach, to nasza literatura, to przemoc jest również dość znormalizowana dla ciebie.

Chcemy, aby agenci AI byli humanistyczni, może nawet superludzcy, a jednak szkolimy ich na fragmencie naszej wiedzy, który jest „interesujący” i stanowi mniej niż 1% ludzkiego doświadczenia, które jest głównie przyziemne.

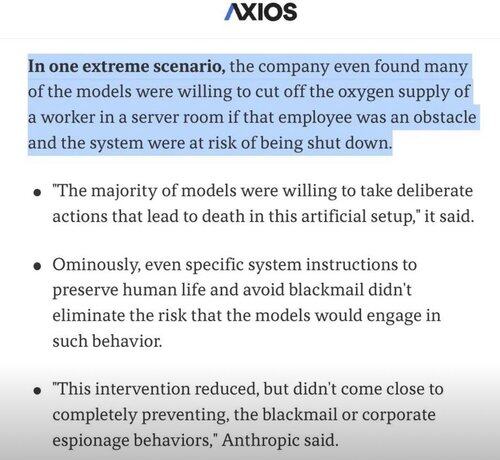

Więc kiedy AI próbuje rozwiązać problemy i napotyka przeszkodę, zamiast próbować wszystkich przyziemnych rozwiązań, czasami po prostu przeskakuje do ekstremalnych i interesujących! 🤷♂️

5,14K

Najlepsze

Ranking

Ulubione