Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Wenn Sie Ihre CoTs nicht so trainieren, dass sie gut aussehen, könnten Sie etwas Sicherheit durch deren Überwachung erhalten.

Das scheint gut zu sein!

Aber ich bin skeptisch, ob das zuverlässig genug funktioniert, um tragfähig in einem Sicherheitsfall zu sein.

Außerdem erwarte ich, dass CoTs, wenn das RL skaliert wird, immer weniger lesbar werden.

16. Juli, 00:00

Eine einfache AGI-Sicherheitstechnik: Die Gedanken der KI sind in einfachem Englisch, man muss sie nur lesen.

Wir wissen, dass es funktioniert, mit OK (nicht perfekter) Transparenz!

Das Risiko ist die Fragilität: RL-Training, neue Architekturen usw. bedrohen die Transparenz.

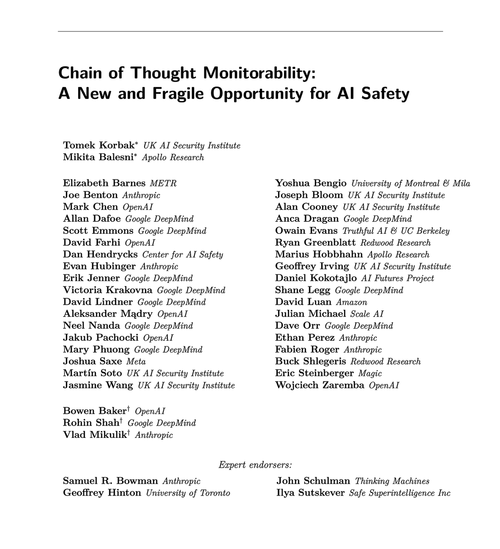

Experten aus vielen Organisationen sind sich einig, dass wir versuchen sollten, sie zu bewahren: 🧵

Um klarzustellen: CoT-Überwachung ist nützlich und kann Ihnen helfen, Fälle von Modell-Hacking-Belohnungen, gefälschter Ausrichtung usw. zu entdecken.

Aber das Fehlen von schlechten "Gedanken" ist kein Beweis dafür, dass das Modell ausgerichtet ist. Es gibt viele Beispiele für produktive LLMs, die irreführende CoTs haben.

Viele gravierende Sicherheitsfehler erfordern wahrscheinlich eine Argumentation, was für LLMs oft schwierig ist, ohne ihre Absichten im CoT zu zeigen.

Wahrscheinlich. Oft. Viele Vorbehalte.

Die Autoren dieses Papiers sagen dies; ich bin nur pessimistischer als sie, wie nützlich das sein wird.

65,9K

Top

Ranking

Favoriten