トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

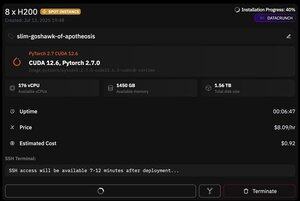

しかし、@PrimeIntellectの素晴らしいところは、スポットインスタンスの可用性です -- 今日、私は8xH200のノードをわずか8ドル/時間で手に入れました!

vllmを使用してmoonshotai/Kimi-K2-Instruct推論をすばやく設定する方法を紹介します

1. ポッドへの SSH アクセスを取得したら (約 10 分待ちます)、プロジェクトを作成し、必要なライブラリをインストールします。

apt update && apt install htop tmux

UVイニシエーション

UVベンブン-P 3.12

ソース:.venv/bin/activate

エクスポート UV_TORCH_BACKEND=auto

エクスポート HF_HUB_ENABLE_HF_TRANSFER="1"

UV pip vllm blobfile データセット huggingface_hub hf_transfer

その後、tmuxセッションを開きます

2. vllm のホスティングを開始するには、vllm serve を使用するだけです。

vllm serve moonshotai/Kimi-K2-Instruct --trust-remote-code --dtype bfloat16 --max-model-len 12000 --max-num-seqs 8 --quantization="fp8" --tensor_parallel_size 8

実際のチェックポイントのダウンロードは、hf_transferでも1時間かかるため、困難です(誰かがより迅速な解決策を知っているか、ダウンロードしたチェックポイントをどういうわけかマウントしますか?

3.次に、新しいtmuxペインにcloudflareクイックトンネルをインストールして開始します

Cloudflaredのインストール

cloudflaredトンネル--url

基本的にはそれだけです!OpenAI互換のサーバーは、Cloudflareが提供するURLで利用可能になりますが、私の場合はOpenAIクライアント上のシンプルなラッパーを使用して、それを介して大量の合成データを生成するだけです

38.7K

トップ

ランキング

お気に入り