熱門話題

#

Bonk 生態迷因幣展現強韌勢頭

#

有消息稱 Pump.fun 計劃 40 億估值發幣,引發市場猜測

#

Solana 新代幣發射平臺 Boop.Fun 風頭正勁

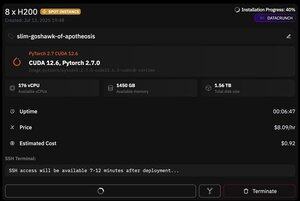

但 @PrimeIntellect 的一個優點是提供即時實例 -- 今天我以每小時僅 $8 的價格獲得了一個 8xH200 的節點!

我將展示如何快速設置 moonshotai/Kimi-K2-Instruct 推理,使用 vllm

1. 獲得 SSH 訪問您的 pod 後(大約等待 10 分鐘),創建您的項目並安裝所需的庫:

apt update && apt install htop tmux

uv init

uv venv -p 3.12

source .venv/bin/activate

export UV_TORCH_BACKEND=auto

export HF_HUB_ENABLE_HF_TRANSFER="1"

uv pip install vllm blobfile datasets huggingface_hub hf_transfer

之後,打開一個 tmux 會話

2. 要開始托管 vllm,您只需使用 vllm serve:

vllm serve moonshotai/Kimi-K2-Instruct --trust-remote-code --dtype bfloat16 --max-model-len 12000 --max-num-seqs 8 --quantization="fp8" --tensor_parallel_size 8

實際的檢查點下載很困難,因為即使使用 hf_transfer 也需要 1 小時(有沒有人知道更快的解決方案或以某種方式掛載已下載的檢查點?)

3. 然後在新的 tmux 窗格中安裝 cloudflare quick tunnel 並啟動它

install cloudflared

cloudflared tunnel --url

基本上就是這樣!一個與 OpenAI 兼容的伺服器將在 Cloudflare 提供的 URL 上可用,在我的情況下是,並且我只是使用我對 openai 客戶端的簡單包裝來通過它生成大量合成數據。

38.65K

熱門

排行

收藏