Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

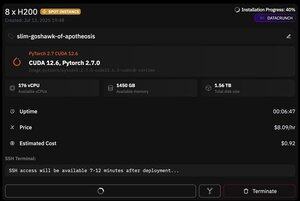

men det som er bra med @PrimeIntellect er tilgjengeligheten av spotforekomster - i dag fikk jeg en node med 8xH200 for bare $8/time!

Jeg skal vise hvordan jeg raskt setter opp moonshotai/Kimi-K2-Instruct-inferens ved hjelp av vllm

1. Etter å ha fått SSH-tilgang til poden din (vent ca. 10 minutter), opprett prosjektet ditt og installer de nødvendige bibliotekene:

apt oppdatering og apt installer htop tmux

uv init

UV VENV -P 3.12

kilde .venv/bin/activate

eksport UV_TORCH_BACKEND=automatisk

eksport HF_HUB_ENABLE_HF_TRANSFER="1"

uv pip install vllm blobfile datasett huggingface_hub hf_transfer

Deretter åpner du en tmux-økt

2. For å begynne å være vert for vllm bruker du bare vllm-server:

vllm serve moonshotai/Kimi-K2-Instruct --trust-remote-code --dtype bfloat16 --max-model-len 12000 --max-num-seqs 8 --quantization="fp8" --tensor_parallel_size 8

Faktisk nedlasting av sjekkpunkt er vanskelig, siden selv med hf_transfer vil det ta 1 time (noen som vet en raskere løsning eller montering av nedlastet sjekkpunkt på en eller annen måte?)

3. Deretter installerer du cloudflare quick tunnel i en ny tmux-rute og starter den

installere Cloudflared

Skyutstrakt tunnel --url

Det er i bunn og grunn det! En OpenAI-kompatibel server vil være tilgjengelig på URL-en levert av Cloudflare, i mitt tilfelle er det det, og jeg bruker bare min enkle innpakning over openai-klienten for å generere mye syntetisk data gjennom den

38,65K

Topp

Rangering

Favoritter