Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

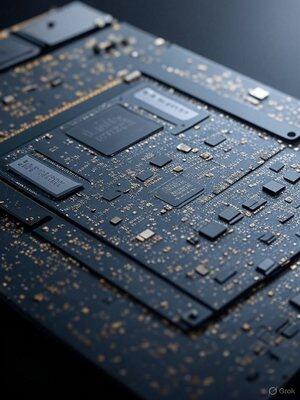

Turbolad Nvidia AI GPUer: Enkle triks for lynrask ytelse

I garasjen min må jeg gjøre det lille ikke-VC-investorer forskning og utvikling, jobbe, jeg har øre og få høyere hastighet enn selskaper med milliarder. Denne begrensningen får meg til å finne måter å presse mer ut av mindre. Jeg gjør mange ting de fleste ikke kan tenke på. Her er et eksempel på bare én av 100-tallet.

GPU-er er kraftsentre, fullpakket med tonnevis av prosessorenheter som er klare til å knuse tall. Jeg oppdaget Men ofte blir de ikke utnyttet fullt ut, noe som fører til treg ytelse.

Hva oppdaget jeg? Smarte optimaliseringer som holder disse enhetene i gang, kutter AI-gjengivelsestider og leverer massive hastighetsøkninger.

Først må du oppdage flaskehalsene.

Jeg bruker profileringsverktøy som Nvidias Nsight for å se hva som holder ting tilbake, enten det er minneventing eller andre ting. Når jeg er identifisert, dykker jeg inn og justerer koden for å pakke mer arbeid inn i hver tråd.

Enkle endringer som å rulle ut sløyfer eller komprimere data kan skjule forsinkelser og øke gjennomstrømningen, noe som gir umiddelbare hastighetshopp.

Høy bruk kan noen ganger forårsake cache-kaos – fiks det ved å redusere antall tråder på en smart måte med dummy-kode eller minnejusteringer, og frigjøre ressurser for parallelle oppgaver.

Den virkelige game-changeren? Asynkron databehandling. Kjør flere oppgaver side ved side, fyll tomgangshull og overlappende tung last. Sammenkobling av minnekrevende oppgaver gir GPU-fleroppgavekjøring – potensielt halvere tider og øke effektiviteten.

Disse justeringene forvandler underbrukte GPUer til fartsdemoner. Det er ikke ulikt hvordan IBM PC/ATs personlige datamaskiner ble forvandlet til å kjøre opp til 100MHz i 1986 da de kom ut av fabrikken på 8MHz.

Jeg skal skrive flere detaljer om dette, men hvis store AI-selskaper brukte min Nvidia GPU-optimalisering på op-kodenivå, ville de sannsynligvis nå AGI, ganske raskt.

Når du kjenner maskinvare og programvare på nesten atomnivå, kan du gjenskape de første prinsippene.

Topp

Rangering

Favoritter