Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Har noen prøvd RL for å omskrive oppfordringer til resonneringsmodeller for å forbedre resultatene ytterligere?

Jeg antar det, det føles ganske åpenbart, men hvis ikke vil jeg prøve det.

Hvis du vet om noe eksisterende arbeid her, pls lmk så jeg ikke gjør om noe folk allerede har gjort!

Med dette mener jeg:

- Ta en allerede trent, frossen resonneringsmodell (dvs. o4-mini via API)

- Legg til en mindre LLM som tar inn en ledetekst, og skriver den om for å forbedre hvordan den frosne modellen fungerer

- Oppdater vektene til den mindre LLM, hold den større LLM-en frossen

Håpet er at den lille LLM-en vil lære å "styre" CoT til den frosne større modellen bedre enn et menneske kunne, noe som øker ytelsen.

@corbtt minnet meg om dette verket av @brendanh0gan...

Brendan, hvordan gikk det? Virker ganske likt det jeg tenker her.

3. juli, 08:26

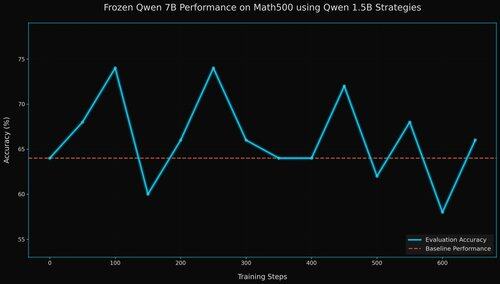

Store modeller er gode agenter, men ofte for store, lukkede eller delikate til å finjustere

Idé: Tren en liten modell til å lage kontekst for en frossen stor modell, rangere den store modellens resultater, bruke den som belønning for den lille

GRPO for kontekstjustering. Mer nedenfor

17,5K

Topp

Rangering

Favoritter