Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

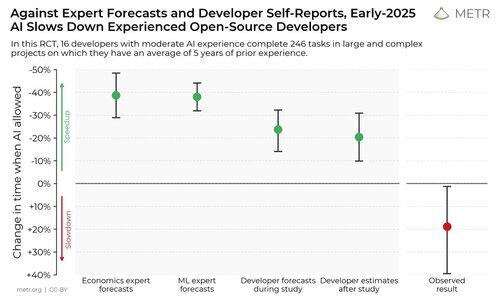

Vi kjørte en randomisert kontrollert studie for å se hvor mye AI-kodeverktøy fremskynder erfarne åpen kildekode-utviklere.

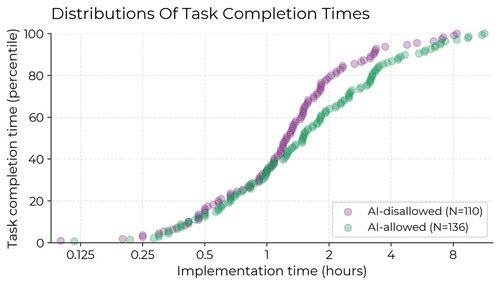

Resultatene overrasket oss: Utviklere trodde de var 20 % raskere med AI-verktøy, men de var faktisk 19 % tregere når de hadde tilgang til AI enn når de ikke hadde det.

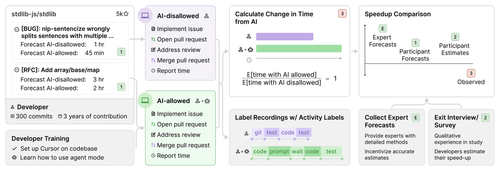

Vi rekrutterte 16 erfarne åpen kildekode-utviklere til å jobbe med 246 virkelige oppgaver i sine egne depoter (gjennomsnitt 22k+ stjerner, 1M+ linjer med kode).

Vi tildelte hver oppgave tilfeldig til enten å tillate AI (vanligvis Cursor Pro med Claude 3.5/3.7) eller ikke tillate AI-hjelp.

I begynnelsen av studien spådde utviklere at de ville bli fremskyndet med 24 %. Etter å ha gjort jobben, anslo de at de hadde blitt fremskyndet med 20 %. Men det viste seg at de faktisk ble bremset med 19 %.

Når AI er tillatt, bruker utviklere mindre tid på å aktivt kode og søke etter informasjon, og bruker i stedet tid på å spørre AI, vente på/gjennomgå AI-utdata og inaktiv. Vi finner ingen enkelt årsak til nedgangen – den er drevet av en kombinasjon av faktorer.

Hvorfor kjørte vi denne studien?

AI-agentreferanser har begrensninger – de er selvstendige, bruker algoritmisk poengsum og mangler live menneskelig interaksjon. Dette kan gjøre det vanskelig å utlede direkte innvirkning i den virkelige verden.

Hvis vi vil ha et tidlig varslingssystem for om AI FoU blir akselerert av AI selv, eller til og med automatisert, vil det være nyttig å kunne måle dette direkte i virkelige ingeniørforsøk, i stedet for å stole på proxyer som benchmarks eller enda mer støyende informasjon som anekdoter.

Hva tar vi med oss?

1. Det virker sannsynlig at for noen viktige innstillinger har nyere AI-verktøy ikke økt produktiviteten (og kan faktisk redusere den).

2. Selvrapporter om hastighet er upålitelige – for å forstå AIs innvirkning på produktiviteten, trenger vi eksperimenter i naturen.

401,33K

Topp

Rangering

Favoritter