Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Kangwook Lee

UW Madison / KRAFTON AI

LLM jako rozhodčí se stal dominantním způsobem, jak hodnotit, jak dobrý je model při řešení úkolu, protože funguje bez testovací sady a zpracovává případy, kde odpovědi nejsou jedinečné.

Ale i přes to, jak široce se toto používá, téměř všechny hlášené výsledky jsou silně zaujaté.

Těšíme se, že můžeme sdílet náš preprint o tom, jak správně používat LLM jako soudce.

🧵

===

Jak tedy lidé vlastně používají LLM jako soudce?

Většina lidí používá LLM jen jako hodnotitele a uvádí empirickou pravděpodobnost, že LLM řekne, že odpověď vypadá správně.

Když je LLM dokonalý, funguje to dobře a poskytuje nestranný odhad.

Pokud LLM není dokonalý, tento se rozbije.

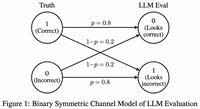

Uvažujme případ, kdy LLM vyhodnocuje správně 80 procent času.

Konkrétněji, pokud je odpověď správná, LLM říká "to vypadá správně" s 80% pravděpodobností, a stejných 80 % platí, když je odpověď skutečně nesprávná.

V této situaci byste neměli empirickou pravděpodobnost uvádět, protože je zaujatá. Proč?

Nechť skutečná pravděpodobnost správné testovaného modelu je p.

Pak empirická pravděpodobnost, že LLM řekne "správně" (= q), je

q = 0,8p + 0,2(1 - p) = 0,2 + 0,6p

Takže nestranný odhad by měl být

(q - 0,2) / 0,6

Situace je ještě zajímavější, pokud je chybový vzor asymetrický nebo pokud tyto chybovosti neznáte předem.

===

Co to tedy znamená?

Nejprve dodržujte doporučené pokyny v našem preprintu.

Oběd zdarma není. Nemůžete hodnotit, jak dobrý je váš model, pokud váš LLM jako rozhodčí není známý tím, že je v jeho hodnocení dokonalý.

Podle toho, jak blízko je k dokonalému evalátoru, potřebujete dostatečnou velikost testovací množiny (= kalibrační sady) k odhadu chybovosti hodnotitele, a pak je musíte korigovat.

Za druhé, velmi bohužel, mnoho zjištění, která jsme viděli v článcích v posledních letech, je třeba znovu přehodnotit.

Pokud dva články nepoužívaly stejný LLM jako soudce, porovnání výsledků mezi nimi mohlo vést k nepravdivým tvrzením. Zlepšení může jednoduše přijít z mírné změny hodnotícího procesu. Naléhavě je potřeba důkladná metastudie.

===

Shrnutí:

(1) Téměř všechna hodnocení LLM jako soudce v posledních letech byla hlášena s zaujatým odhadcem.

(2) Je snadné to opravit, proto počkejte na náš kompletní preprint.

(3) Mnoho výsledků LLM jako soudce by mělo být bráno s rezervou.

Celý preprint vyjde za pár dní, tak zůstaňte naladěni!

Úžasná práce mých studentů a spolupracovníků.

@chungpa_lee @tomzeng200 @jongwonjeong123 a @jysohn1108

203,79K

Vážnější vlákno o humbuku kolem DeepSeek-OCR / závažné dezinterpretaci, která probíhá.

1.

Pokud jde o redukci tokenů prostřednictvím reprezentace textu v obrázcích, výzkumníci z Cambridge již dříve ukázali, že je možná 500x rychlá komprese tokenů (ACL'25, Li, Su a Collier).

Bez použití myšlenky převodu textu na obrázky.

2.

Úspěch OCR DeepSeek bychom neměli připisovat síle reprezentace obrazu.

Zároveň není nic zásadně špatného na reprezentaci textu pomocí jakéhokoli tokenizátoru.

Ve skutečnosti můžete udělat opak toho, co udělal DeepSeek-OCR, tj. můžete obrázky reprezentovat jako sekvenci textových tokenů (z nichž každý představuje své hodnoty RGB) a věci budou fungovat dobře. (Viz článek LIFT.)

3.

Jediným správným závěrem je, že současné vkládací prostory používané LLM jsou prostě obrovské a možná dokonce velmi nehospodárné.

A co je důležité, zatím je plně nevyužíváme.

4.

Existuje mnoho nedávných důkazů podporujících stejné poselství.

Například je ukázáno, že pokud poskytnete kontextové ukázky z více úloh, ale smíchaných v jednom kontextu, pak váš model může řešit více úloh predikce ICL současně. (Viz článek VŠECHNO, VŠUDE, NAJEDNOU.)

5.

tldr;

- DeepSeek-OCR je v pohodě

- ale vyšší míry redukce tokenů můžete dosáhnout pouhým doladěním LLM na stlačených textových tokenech

- existuje více důkazů o tom, že LLM plně nevyužívají velký prostor pro vkládání a obrovské množství výpočetních prostředků, které jdou dovnitř v době odvozování

- a to je jediné skutečné poznatek, který byste si měli odnést

85,94K

DLLM vypadají slibně... Paralelní generování však není vždy možné

LLM založené na difúzi mohou generovat mnoho tokenů na různých pozicích najednou, zatímco většina autoregresivních LLM generuje tokeny jeden po druhém.

Díky tomu jsou LLM založené na difúzi velmi atraktivní, když potřebujeme rychlou generaci s menším výpočetním výkonem.

Velkou otázkou je... Je možné paralelní generování bez ztráty přesnosti modelování?

Odpověď zní ne. Existují základní limity toho, jak velkého paralelismu můžeme dosáhnout.

Uvažujme tento příklad:

"Vyberte si jednotně náhodně jedno město z následujících čtyř měst:

New York, New Orleans, Mexico City nebo Panama City."

Potom

P(Y₁ = nový, Y₂ = York) = 1/4,

P(Y₁ = nový, Y₂ = Orleánský) = 1/4 a tak dále.

Tedy P(Y₁ = Nový) = 1/2, P(Y₂ = Město) = 1/2.

Pokud se rozhodnete generovat Y₁ a Y₂ paralelně, bez ohledu na to, jaký dekódovací algoritmus použijete...

Jste odsouzeni k tomu, abyste si vyzkoušeli "New City".

Žádný z dnešních modelů DLL nedokáže tyto dvě slova správně vygenerovat, aniž by se vzdal paralelismu.

-----

Proč tomu tak je?

Ve skutečnosti nikdy netrénujeme LLM, aby se naučili společné rozdělení přes více tokenů v jedné dopředné iteraci.

Vždy vyučujeme jednotokenové marginální rozdělení podmíněné kontextem.

(Totéž platí i pro autoregresní modely.)

Proto je vzorkování více tokenů najednou možné pouze v případě, že jsou tyto tokeny vzájemně nezávislé vzhledem k aktuálnímu kontextu.

A toto omezení paralelního vzorkování lze přesně formalizovat.

Lze odvodit informačně-teoretickou limitu, která je agnostická vůči dekódovací strategii, a také odvodit limity specifické pro strategii.

-----

Jsou tedy DLLM odsouzeny k zániku? Ne!

Mají obrovský potenciál ušetřit výpočetní prostředky a čas.

Ale:

(1) musíme si být vědomi jejich základních omezení a

(2) musíme navrhnout lepší strategie školení a dekódování.

Zejména je zde obrovský prostor pro zlepšení v dekódování.

Proč?

V ideálním případě chceme, aby model řídil stupeň paralelismu během generování.

Zároveň by měla zvolit podmnožinu budoucích tokenů, které jsou vzhledem k aktuálnímu kontextu téměř vzájemně nezávislé.

Jsou v tom současné dekódovací strategie dobré?

Těžko říct.

Většina DLL knihoven pro něj nikdy nebyla testována zátěží.

-----

Proto jsme zavedli syntetický benchmark pro zátěžové testování knihoven DLLM.

Říkáme tomu ParallelBench.

Myšlenka je jednoduchá: jedná se o úlohy v přirozeném jazyce, ale pečlivě navržené tak, aby paralelní generování bylo ze své podstaty obtížné.

(Vzpomeňte si na "Nové město", ale přirozenější, skutečné úkoly.)

Co jsme zjistili?

Testovali jsme populární DLLM s různými dekódovacími algoritmy a žádný z nich se nepřiblížil výkonu "oracle", což je ideální výkon, který byste získali, pokud by model dokázal optimálně upravit svůj paralelismus během dekódování.

-----

Stánek s jídlem:

(1) Paralelní generování není vždy možné a další podrobnosti najdete v našem dokumentu :)

(2) Pokud dokážete navrhnout knihovnu DLLM, která odpovídá výkonu Oracle v našem benchmarku, no, kdo ví, možná vám zavolá někdo z Menlo Parku. 😉

63,68K

Top

Hodnocení

Oblíbené