熱門話題

#

Bonk 生態迷因幣展現強韌勢頭

#

有消息稱 Pump.fun 計劃 40 億估值發幣,引發市場猜測

#

Solana 新代幣發射平臺 Boop.Fun 風頭正勁

Kangwook Lee

威斯康辛大學麥迪遜分校 / 克拉夫頓 AI

作為評判的 LLM 已經成為評估模型解決任務能力的主流方式,因為它不需要測試集,並且能處理答案不唯一的情況。

但儘管這種方法被廣泛使用,幾乎所有報告的結果都是高度偏見的。

很高興與大家分享我們的預印本,介紹如何正確使用 LLM 作為評判。

🧵

===

那麼人們實際上是如何使用 LLM 作為評判的呢?

大多數人只是將 LLM 作為評估者,並報告 LLM 認為答案看起來正確的經驗概率。

當 LLM 完美時,這樣做很好,並且提供了一個無偏的估計。

如果 LLM 不完美,這就會失效。

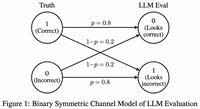

考慮一個情況,LLM 正確評估的概率為 80%。

更具體地說,如果答案是正確的,LLM 以 80% 的概率說「這看起來正確」,而當答案實際上不正確時,這 80% 的概率也適用。

在這種情況下,你不應該報告經驗概率,因為它是有偏的。為什麼?

讓被測模型正確的真實概率為 p。

那麼 LLM 說「正確」的經驗概率 (= q) 為

q = 0.8p + 0.2(1 - p) = 0.2 + 0.6p

所以無偏估計應該是

(q - 0.2) / 0.6

如果錯誤模式不對稱或你不知道這些錯誤率的先驗值,情況會變得更加有趣。

===

那這意味著什麼?

首先,遵循我們預印本中的建議指導方針。

沒有免費的午餐。除非你的 LLM 作為評判被認為是完美的,否則你無法評估你的模型有多好。

根據它與完美評估者的接近程度,你需要足夠大小的測試集 (= 校準集) 來估計評估者的錯誤率,然後你必須對其進行修正。

其次,非常不幸的是,我們在過去幾年中看到的許多研究結果需要重新檢視。

除非兩篇論文使用完全相同的 LLM 作為評判,否則在它們之間比較結果可能會產生錯誤的聲明。改進可能僅僅來自於稍微改變評估流程。迫切需要進行嚴謹的元研究。

===

tldr:

(1) 過去幾年幾乎所有 LLM 作為評判的評估都是用有偏的估計器報告的。

(2) 這很容易修正,所以請等待我們的完整預印本。

(3) 許多 LLM 作為評判的結果應該謹慎對待。

完整的預印本即將在幾天內發布,敬請期待!

我的學生和合作者們做了驚人的工作。

@chungpa_lee @tomzeng200 @jongwonjeong123 和 @jysohn1108

203.82K

關於 DeepSeek-OCR 的炒作 / 嚴重誤解的更嚴肅的討論。

1.

關於通過在圖像中表示文本來減少標記,劍橋的研究人員之前已經顯示出 500 倍的提示標記壓縮是可能的(ACL'25,Li,Su 和 Collier)。

不使用將文本轉換為圖像的想法。

2.

我們不應該將 DeepSeek OCR 的成功歸因於圖像表示的力量。

同時,使用任何標記器進行文本表示並沒有根本上的錯誤。

事實上,你可以做 DeepSeek-OCR 所做的相反的事情,即你可以將圖像表示為一系列文本標記(每個標記表示其 RGB 值),這樣一切都會運行良好。(參見 LIFT 論文。)

3.

唯一正確的結論是,目前 LLM 使用的嵌入空間是巨大的,甚至可能非常浪費。

而且重要的是,我們尚未充分利用它們。

4.

最近有很多證據支持相同的信息。

例如,顯示如果你在單一上下文中提供來自多個任務的上下文演示,那麼你的模型可以同時解決多個 ICL 預測任務。(參見 EVERYTHING EVERYWHERE ALL AT ONCE 論文。)

5.

tldr;

- DeepSeek-OCR 很酷

- 但你可以通過對壓縮的文本標記進行微調 LLM 來實現更高的標記減少率

- 還有更多證據表明 LLM 沒有充分利用大型嵌入空間以及在推理時投入的巨大計算量

- 這是你應該記住的唯一真正的結論

85.99K

DLLMs 看起來很有前景……但平行生成並不總是可能的

基於擴散的 LLM 可以同時在不同位置生成許多標記,而大多數自回歸 LLM 則是逐個生成標記。

這使得基於擴散的 LLM 在需要快速生成且計算量較少的情況下非常有吸引力。

一個大問題是……在不失去建模準確性的情況下,平行生成是否可能?

答案是否定的。我們能實現的平行性有基本的限制。

考慮這個例子:

“從以下四個城市中均勻隨機選擇一個城市:

紐約、新奧爾良、墨西哥城或巴拿馬城。”

然後,

P(Y₁ = New, Y₂ = York) = 1/4,

P(Y₁ = New, Y₂ = Orleans) = 1/4,等等。

因此,P(Y₁ = New) = 1/2,P(Y₂ = City) = 1/2。

如果你選擇平行生成 Y₁ 和 Y₂,無論你使用哪種解碼算法……

你注定會抽樣出“New City”。

當今的 DLLMs 沒有一個能在不放棄平行性的情況下正確生成這兩個詞。

-----

為什麼會這樣?

事實上,我們從未訓練 LLM 學習在一次前向迭代中多個標記的聯合分佈。

我們總是教導基於上下文的單標記邊際分佈。

(自回歸模型也是如此。)

因此,只有在這些標記在當前上下文下相互獨立的情況下,才能同時抽樣多個標記。

而這種平行抽樣的限制可以精確地形式化。

可以推導出一個與解碼策略無關的信息理論極限,還可以推導出特定策略的極限。

-----

那麼 DLLMs 是不是注定失敗?不!

它們有巨大的潛力來節省計算和時間。

但是:

(1)我們需要意識到它們的基本限制,並且

(2)我們需要設計更好的訓練和解碼策略。

特別是,解碼方面有很大的改進空間。

為什麼?

理想情況下,我們希望模型在生成過程中控制平行性的程度。

同時,它應該選擇一組在當前上下文下幾乎相互獨立的未來標記。

當前的解碼策略在這方面表現如何?

難以判斷。

大多數 DLLMs 從未經受過這方面的壓力測試。

-----

這就是為什麼我們引入了一個合成基準來壓力測試 DLLMs。

我們稱之為 ParallelBench。

這個想法很簡單:這些是自然語言任務,但經過精心設計,使得平行生成本質上很困難。

(想想“New City”,但更自然、更真實的任務。)

我們發現了什麼?

我們測試了流行的 DLLMs 和各種解碼算法,沒有一個接近“oracle”性能,即如果模型能在解碼過程中最佳調整其平行性所能達到的理想性能。

-----

要點:

(1)平行生成並不總是可能,更多細節請查看我們的論文 :)

(2)如果你能設計一個在我們的基準上達到 oracle 性能的 DLLM,那麼,誰知道呢,你可能會接到來自門洛公園某人的電話。😉

63.81K

熱門

排行

收藏