Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

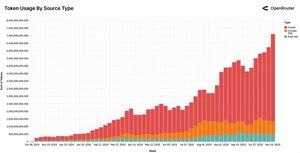

Den största AI-användningsrapporten 2025 har precis släppts (100 biljoner tokens av verklig användning på OpenRouter)

8 fynd som jag blev mest förvånad över:

1. Rollspel och kreativ fiktion är den näst största kategorin och >50 % av all användning av öppen källkod. Ocensurerade modeller slukar efterfrågan på "-fic" och NSFW-innehåll.

2. Programmering utgör nu >50 % av alla LLM-tokens. Det var 11 % för tolv månader sedan. Kodning blev bokstavligen AI:s operativsystem.

3. Anthropics Claude används för >80 % programmering och nästan inget rollspel. Det är modellen för "seriöst arbete" medan DeepSeek är underhållningskungen (med 2/3 rollspelstrafik)

4. En modell där den första som klarar en smärtsam arbetsbelastning skapar nästan permanent låsning. Tidiga kohorter av Claude 4 Sonnet och Gemini 2.5 Pro behåller fortfarande 40–50 % av användarna sex månader senare, medan varje senare kohort churner.

De kallar det Glasskor-effekten: var den första att ta in en ny arbetsbörda, och prinsessan lämnar aldrig platsen.

5. Efterfrågan är extremt prisinelastisk. Användare betalar gärna 10–50× mer per token för Claude eller GPT-5 om det sparar dem tio minuters felsökning. Att vara snål räcker inte alls.

6. Den nya sweetspot-modellstorleken är 20–70 miljarder parametrar. Små modeller används lite, jättelika modeller fragmenteras och mellanklassen äter upp båda.

7. Öppna källkodsmodeller gick från <5 % till ~33 % av den totala användningen på ett år, nästan helt drivet av kinesiska laboratorier (DeepSeek, Qwen, Moonshot, MiniMax). Det finns inte längre någon enda bästa modell. De tio bästa modellerna sett till volym kommer från åtta olika laboratorier.

8. Asien står nu för 31 % av den globala konsumtionen (var 13 % för ett år sedan). Singapore + Kina + Korea utgör enbart nästan 20 % av alla tokens.

Eran med en grundmodell som styrde dem är över. Vi lever nu i en permanent fragmenterad värld där modellen du använder helt beror på vad du gör med den – skriver kod? Skriver du fanfics?

Hur som helst, det finns uppenbarligen bara en riktning för token-spendering: Upp och åt höger

Fullständig rapport från @a16z + @OpenRouterAI (länk i kommentarerna).

Topp

Rankning

Favoriter