Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

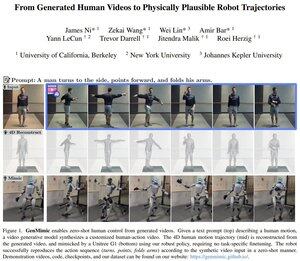

Är detta Yann LeCuns första artikel efter att ha lämnat Meta?

Den visar hur humanoida robotar kan efterlikna handlingar från AI-genererade videor, som ofta är för bullriga för att kunna efterliknas direkt.

Systemet lyfter videon till 3D-nyckelpunkter och använder sedan en fysikmedveten policy för att utföra rörelserna, vilket möjliggör noll-skott-kontroll.

De implementerade detta på Unitree G1 humanoidroboten.

Topp

Rankning

Favoriter