Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

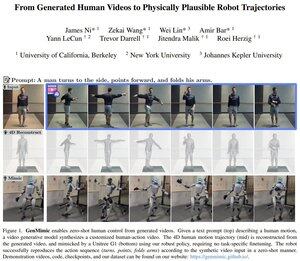

Is dit Yann LeCun's eerste paper na zijn vertrek bij Meta?

Het toont aan hoe humanoïde robots acties kunnen nabootsen vanuit AI-gegenereerde video's, die vaak te ruisachtig zijn voor directe imitatie.

Het systeem tilt de video naar 3D-sleutelpunten en gebruikt vervolgens een fysica-bewuste strategie om de bewegingen uit te voeren, waardoor zero-shot controle mogelijk is.

Ze hebben dit geïmplementeerd op de Unitree G1 humanoïde robot.

Boven

Positie

Favorieten